DeepMind dit avoir trouvé le moyen pour qu’une intelligence artificielle se souvienne de ses erreurs. Une mémoire pour quoi faire ?

Présentation

Après la victoire d’AlphaGo contre un champion de jeu de go et les rêveries de Deep Dream, la filiale de Google consacrée à l’intelligence artificielle a fait savoir qu’elle progressait vers la constitution d’un algorithme capable de mémoriser des tâches effectuées en jouant à des jeux vidéo. Autrement dit, un algo capable d’apprendre de ses erreurs.

C’est une publication qui a fait peu de bruit. Pourtant, on y trouve cette affirmation des chercheurs de DeepMind, la filiale intelligence artificielle (IA) de Google : « Les programmes informatiques qui apprennent à effectuer des tâches les oublient très rapidement. Nous démontrons que les règles d’apprentissage peuvent être modifiées afin qu’un programme se rappelle de ses anciennes fonctions quand il en apprend une autre. C’est une étape importante vers des programmes plus intelligents, capables d’apprendre progressivement tout en s’adaptant ». En somme, DeepMind serait à présent dotée d’une mémoire, qui lui permet de jouer à plusieurs jeux vidéo d’affilée, et d’apprendre progressivement à les maîtriser.

DeepMind a déjà derrière elle un certain nombre de faits d’armes retentissants. De la victoire de son programme AlphaGo contre le troisième joueur mondial de jeu de go, en juillet 2016, au fait de pouvoir jouer à un jeu vidéo basique (Montezuma’s Revenge, sur Atari), l’entreprise rachetée par Google pour 580 millions d’euros en 2014 communique régulièrement sur ses exploits.

Objectif : « résoudre l’intelligence »

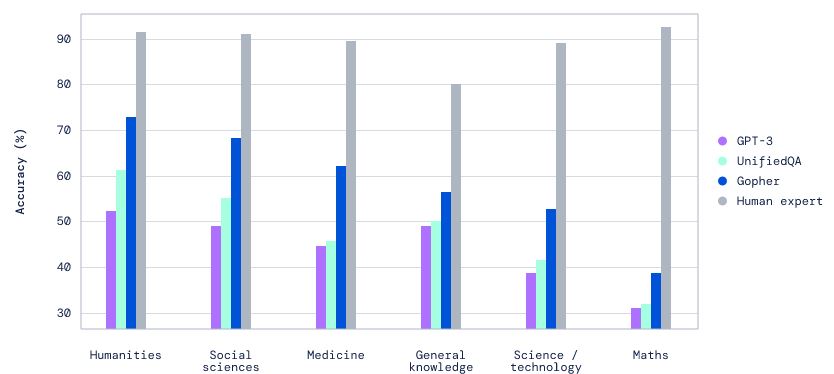

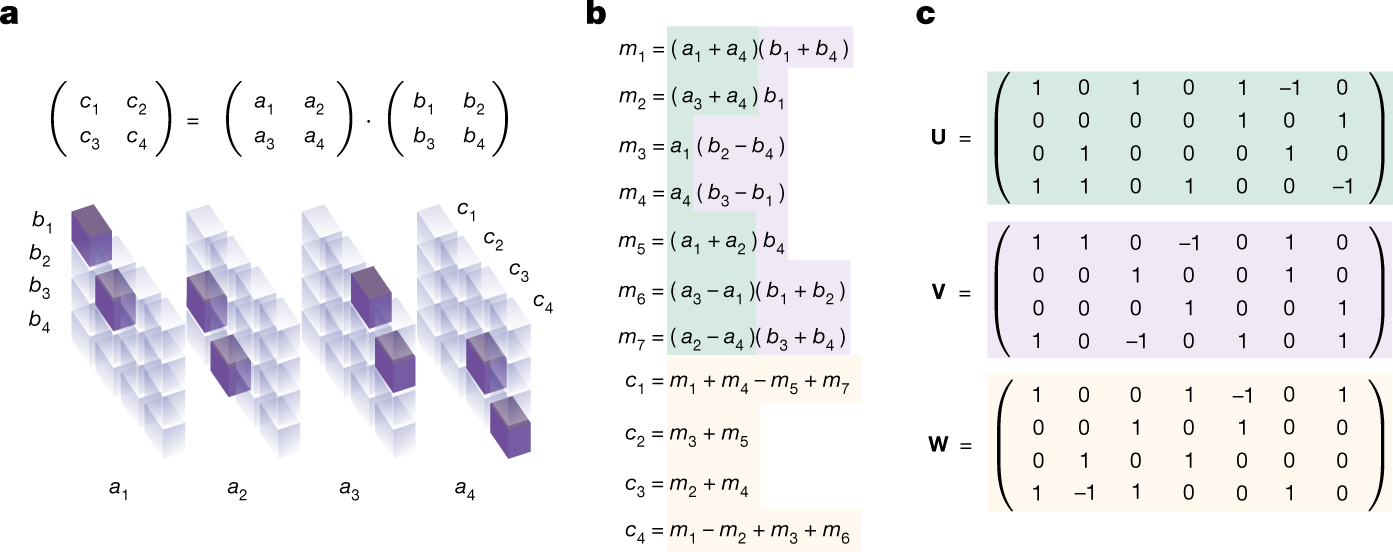

L’objectif claironné par ses fondateurs est clair : « résoudre l’intelligence ». Pour ce faire, DeepMind utilise la technique du deep learning (apprentissage profond), un système d’apprentissage et de classification fondé sur des réseaux de neurones artificiels, déjà utilisé par des assistants virtuels comme Siri, Cortana ou Google Now.

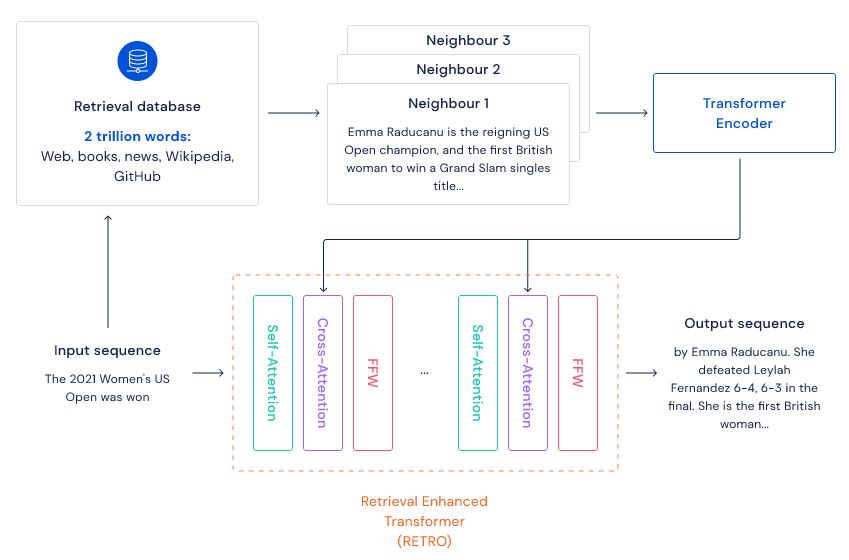

Le système mis en avant par l’étude, baptisé Deep Q-Network a déjà fait ses preuves dans d’autres tests effectués sur des jeux Atari. Il est développé sur le principe du réseau de neurones, « une façon de traiter l’information qui, en gros, est inspirée par le cerveau humain », confie à Usbek & Rica James Kirkpatrick, le directeur de l’étude.

Les ingénieurs de DeepMind se sont penchés sur les connexions synaptiques, qui permettent la mémorisation d’éléments dans une situation donnée afin de pouvoir les réutiliser dans un autre contexte.

« Les réseaux de neurones permettent de traiter n’importe quel type de données »

« Le réseau de neurones permet d’avoir une approche anthropomorphique, même si ses principes existaient avant », précise un chercheur du CEA spécialisé dans l’extraction d’informations multimodales. Concrètement, « ces réseaux permettent de traiter n’importe quel type de données, et sont souvent utilisés pour la reconnaissance de formes ou d’images », note encore James Kirkpatrick.

Si ces réseaux de neurones sont efficaces pour une tâche donnée, il faut encore résoudre un problème fondamental : la machine ne parvient pas à se souvenir. Comme nous le précise James Kirkpatrick, « jusqu’ici, peu de progrès ont été faits pour permettre l’apprentissage séquencé de plusieurs tâches ». Et DeepMind serait justement en train de trouver la solution.

.svg)

.svg)