Courte définition de l’Intelligence Artificielle Générative

L’intelligence artificielle générative se réfère à des systèmes informatiques capables de créer de nouvelles données (d’où le générative), le plus souvent sous la forme de texte, d’images, de sons et même de petites vidéos en se basant sur des modèles préalablement retirés depuis des jeux de données existantes. Ces systèmes utilisent donc, des techniques telles que les réseaux neuronaux générateur pour produire des sorties créatives et originales.

Lire : « L’envers des mots » : Intelligence artificielle générative

Publié sur The Conversation par Thierry Poibeau le 21 janvier 2024

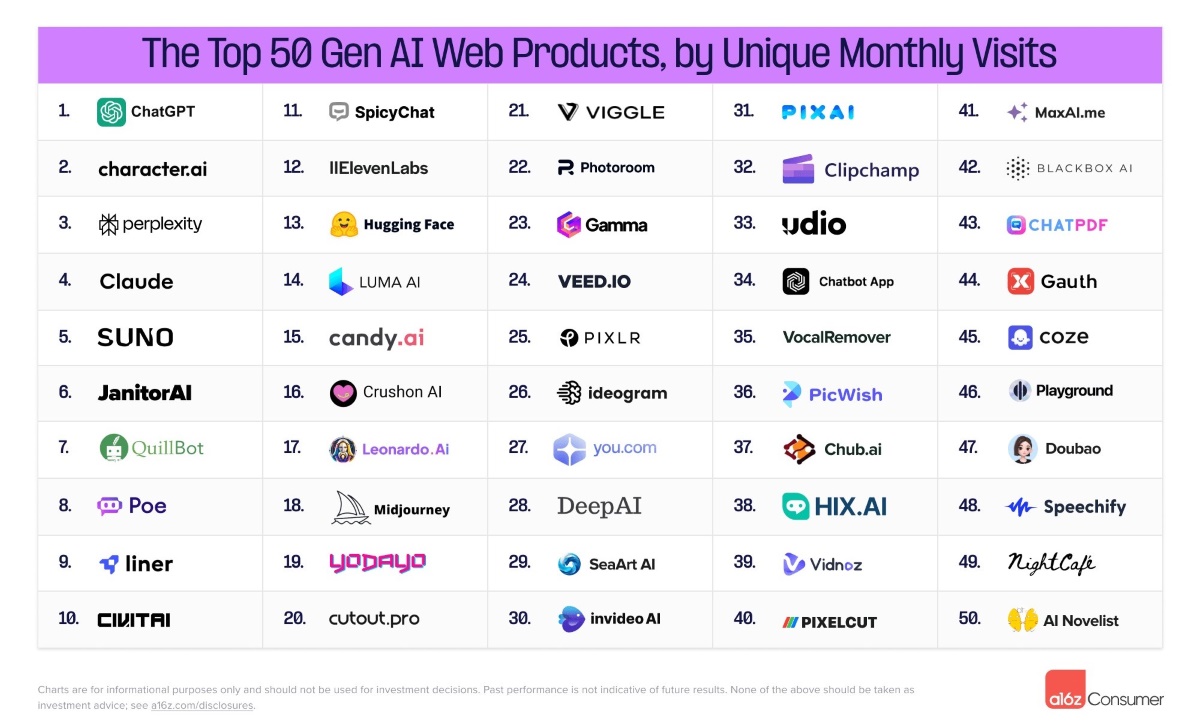

Les 50 outils d’IA générative les plus utilisés en 2024

Les outils d’IA générative les plus utilisés

En se basant sur les visites web mondiales sur ordinateur de bureau et sur mobile, Andreessen Horowitz vient d’établir la liste des 50 outils d’intelligence artificielle générative les plus utilisés au monde en juin 2024. Voici le top 10 des plateformes les plus populaires :

- ChatGPT

- Character.ai

- Perplexity

- Claude

- SUNO

- JanitorAI

- QuillBot

- Poe

- Liner

- CIVITAI

Le livre :

« Comprendre L’IA Générative Tome1 »

Est enfin disponible !

Profitez de cette bible !

Une présentation plus jolie

Constatations

La domination de ChatGPT est indéniable

Sur l’ensemble du top 50, il capte 60 % du trafic mensuel, et est à ce jour le 24e site le plus visité au monde. Toutefois, le chatbot d’OpenAI ne parvient pas encore à se confronter aux géants du web tels que WhatsApp, YouTube, Facebook ou Instagram. Actuellement, il se situe au même rang que Reddit, LinkedIn ou Twitch, preuve que l’IA générative dispose encore d’une marge de progression.

Les assistants généraux sont largement en tête

En ce qui concerne le type d’outils utilisés, ce sont les « assistants généraux » qui tirent leur épingle du jeu, avec 68,7 % des utilisations. Ils sont manifestement boostés par le succès de ChatGPT. En seconde position, on retrouve les « compagnons », comme CharacterAI, qui ont connu une croissance exponentielle à partir de novembre 2022, jusqu’à dépasser les générateurs de contenus (image, voix, vidéo, etc.) comme Midjourney ou ElevenLabs autour du mois de juin.

Les applications mobiles doivent encore se développer

Un autre enseignement crucial mis en avant par Andreessen Horowitz est la faible part d’utilisation des applications mobiles et ce, pour la quasi totalité des outils du top 50. Cette sous-utilisation pourrait s’expliquer par le faible investissement des entreprises dans ce support. Parmi les outils listés, seulement 15 disposent d’une version mobile et « presque toutes voient moins de 10 % de leur trafic mensuel total provenir de leur application plutôt que du web ».

D’après le société d’étude, le développement d’applications mobiles pourrait constituer un axe de progression important pour les outils d’IA générative, étant donné que « le consommateur moyen passe aujourd’hui 36 minutes de plus par jour sur son mobile ».

Lire également : La base vectorielle : cette brique peu connue pourtant au cœur de l’IA générative

Texte, image, vidéo… Elle encode les données non-structurées qui serviront ensuite à entraîner les modèles de fondation. C’est aussi le socle de la recherche intelligente.

(Réservé au abonnés, mais une simple inscription gratuite permet de lire l’article)

Publié sur Le Journal du Net par Antoine Crochet-Damais le 24 novembre 2023

L’IA générative ou l’illusion du déjeuner gratuit

Comme souvent avec les technologies de rupture, l’IA Générative arrive avec son lot d’oracles y voyant pour certains la fin du travail, pour d’autres la mère de toutes les bulles.

Une excellent chronique de Ghislain De Pierrefeu publié sur Le Journal du Net le 13 octobre 2023

OpenIA a visé juste en mettant entre les mains du grand public des technologies puissantes et simples d’usage. Depuis, à chaque jour sa nouvelle annonce sur ce que ces IA pourraient faire à notre place ; impressionnant et questionnant.

Sans m’appesantir sur le clin d’œil au No Free Lunch Theorem de Macready et Wolpert, qui démontre qu’aucun algorithme apprenant n’est optimal pour tous les problèmes… on y trouve un lien avec les croyances récemment renouvelées dans l’IA magique générant de la valeur sans effort.

Hélas, comme c’était le cas pour les IA traditionnelles, il n’y aura pas de déjeuner gratuits pour au moins trois raisons.

Le plan :

- Des technologies en apparence prêtes à l’usage… mais la vérité est plus compliquée

- Des équations économiques encore très incertaines

- Des impacts écologiques et géostratégiques sous-évalués

En conclusion, il serait idiot de ne pas prendre ce virage de l’IA Générative qui recèle plus de promesses que de risques, mais il sera clé de faire des choix de solutions éclairés et équilibré (open-source vs éditeurs), de mesurer les risques long terme en acceptant qu’une solution moins performante à court terme sera peut-être plus durable, et surtout de ne pas lésiner sur les compétences et l’expertise nécessaire à l’appropriation en profondeur de ce nouvel outil.

Une excellent chronique de Ghislain De Pierrefeu publié sur Le Journal du Net le 13 octobre 2023

Huit métiers à suivre dans l’intelligence artificielle

Pour cette article, j’ai conservé les nom anglais ; attendons les traductions officielles…

Prompt Engineer

C’est la profession la plus évoquée en ce moment. Elle pourrait être qualifiée de “dresseur d’IA”. Il s’agit d’un expert qui crée et affine les requêtes ou prompts afin de guider efficacement les systèmes d’IA dans la production des résultats souhaités. Cela reprend le principe de savoir formuler la meilleure requête possible afin d’obtenir et produire les contenus escomptés comme par exemple avec le SQL. Savoir converser avec une intelligence artificielle est une denrée de plus en recherchée.

Deepfake Reviewer

Ce sont des personnes capables de modérer et des vérificateurs a priori. Ces experts détectent et analysent les contenus « deepfake » afin d’empêcher leur diffusion et d’atténuer les dommages potentiels. Ils ont une connaissance parfaite et actualisée des mécanismes de génération d’images et de vidéos. De manière prosaïque, ils savent dissocier le vrai du faux. Ils vérifient l’authenticité d’informations, d’images ou de vidéos, souvent à l’aide d’outils assistés par Al.

Kill Switch Engineer

Ce sont des ingénieurs qui conçoivent et mettent en œuvre des mécanismes de sécurité pour arrêter les systèmes AI en cas de dysfonctionnement ou de mauvaise utilisation. Ils sont chargés de veiller à ce que le système soit sûr et de minimiser les menaces ou les risques potentiels. Pour ce faire, ils doivent connaître les protocoles et l’architecture des réseaux. C’est aussi “le gardien” face au risque d’intrusion. Il doit pouvoir corriger les failles de sécurité éventuelles.

Algorithm Inspector

Ce sont les experts qui examine et analyse les algorithmes d’AI dans les moindres détails pour s’assurer de leur performance, de leur sécurité et de leur conformité éthique. Ces personnes doivent comprendre l’algorithme sous “toutes les coutures”. Ils doivent aussi être capables de maîtriser l’utilisation des techniques telles que l’analyse syntaxique ou encore la validation croisée…

Al Ethics Manager

Ce sont les professionnels chargés de superviser le développement, la mise en œuvre et l’utilisation éthique des systèmes AI. L’évaluation doit prendre en compte, notamment, les principes de vérifiabilité et de traçabilité permettant d’évaluer les algorithmes, les données et les processus de conception, et inclure un examen externe des systèmes d’IA ; sans oublié le RGPD. Il peut aussi prendre en compte les conséquences psychologiques de leur usages sur les utilisateurs.

Al Art Curator

Les curateurs qui évaluent et sélectionnent l’art généré par l’AI, en reconnaissant la valeur et la créativité du travail des artistes de l’intelligence artificielle. Ils peuvent être des commissaires d’exposition qui proposent une sélection d’œuvres générées par des outils d’IA.

AI-Assisted Legal Mediator

Professionnels qui utilisent les outils de l’Al pour faciliter la négociation et la résolution des conflits dans les litiges juridiques. Ils ont développé une expertise dans les prompt et les requêtes juridiques afin d’éviter et de résoudre les contentieux entre les parties.

Al-Powered Storyteller

Ce point regroupe les écrivains qui collaborent avec les systèmes AI pour créer des histoires, des romans, des scénarios ou d’autres œuvres narratives captivantes. Ils mettent à profit leur talent d’écriture pour générer de nouveaux récits grâce aux outils d’IA. Leur imagination sans limite est alimentée par les algorithmes de l’intelligence artificielle.

Une étude révèle que les IA génératives augmente la productivité au travail

C’est la première étude réalisée autour de l’impact de l’intelligence artificielle générative dans le milieu professionnel

Deux équipes de chercheurs du Massachusetts Institute of Technology (MIT) et de l’Université de Stanford ont testé l’impact des outils d’intelligence artificielle générative sur la productivité d’une entreprise. Selon les résultats, les employés du service client d’une entreprise de services du numérique (ESN) classée dans le Fortune 500 sont devenus en moyenne 14 % plus productifs en utilisant l’IA générative que leurs collègues qui ne l’exploitaient pas.

Comment mesurer l’impact de l’IA générative sur les employés ?

D’après les informations recueillies par Bloomberg, ces travaux de recherche constituent la première tentative réalisée pour mesurer l’impact de l’IA générative sur le travail. Des études antérieures ont toutefois déjà permis de comparer les capacités de plusieurs modèles de langages dans certaines tâches issues du secteur médical ou du droit. « Les résultats de certaines de ces expériences antérieures ont montré le potentiel, parfois surprenant, des modèles linguistiques sur le lieu de travail », a affirmé Erik Brynjolfsson, directeur du Digital Economy Lab, au Stanford Institute for Human-Centered AI.

Partant de ce constat que les chercheur ont décidé de suivre les performances de 5 000 employés travaillant pour le service client d’une société basée principalement aux Philippines. Afin de mesurer leur productivité, ils se sont basés sur plusieurs indicateurs clés tels que la rapidité d’identification et de résolution du problème, ou le pourcentage de difficultés officiellement résolues.

Chaque employé a été réparti dans un des deux groupes conçus pour l’occasion. Le premier permettait aux travailleurs d’avoir accès à un outil d’intelligence artificielle de type chatbot. Cette solution a été formée grâce à un large éventail de conversation ayant abouti à la résolution de problèmes par le service client. Le second groupe n’avait pas accès à cet outil, mais il avait la possibilité d’utiliser tous les autres moyens exploités au quotidien pour résoudre le problème des clients.

Des résultats qui mettent en avant l’intérêt de l’intelligence artificielle

L’une des principales conclusions de l’étude met en avant le fait que les employés les moins qualifiés, ceux qui ont généralement le taux de réussite le plus bas, sont ceux qui bénéficient le plus de la technologie. Avec l’aide de l’intelligence artificielle, les travailleurs novices ont effectué leur tâche en moyenne 1,35 fois plus rapidement qu’habituellement. De plus, leurs compétences et leurs performances se sont améliorées beaucoup plus rapidement avec l’IA que sans.

Toujours selon l’étude, les employés avec deux mois d’expérience qui ont été aidés par l’IA ont obtenu des résultats aussi bons, voire meilleurs que ceux présents dans l’entreprise, depuis plus de six mois et qui n’ont pas eu accès à l’outil. En bref, les travaux menés par les trois chercheurs montrent que l’intelligence artificielle a cette faculté d’englober toutes les connaissances utilisées par les meilleurs employés de l’entreprise pour ensuite, les transmettre à ceux qui ont moins d’expérience.

Maintenant, de plus en plus de directions métiers s’intéressent à l’IA générative

Avant même que les résultats de cette enquête ne soient dévoilés au grand public, plusieurs corps de métiers se sont intéressés à l’intelligence artificielle générative. Le patron de BuzzFeed, Jonah Peretti, avait fait une annonce pour le moins étonnante au début de l’année. Il avait affirmé à ses employés que cette technologique pouvait être utilisée « comme une source d’inspiration et comme un outil accompagnant le processus de création ou d’amélioration de contenu ».

Depuis la sortie de ChatGPT en novembre dernier, de multiples utilisations de cet outil ont pu être mises en avant. Les développeurs peuvent s’en servir pour créer du code ou pour être guidés afin de mettre au point un algorithme. General Motors souhaite l’exploiter pour en faire un assistant à la conduite. Des écrivains utilisent même cet outil pour rédiger des e-books pour ensuite les revendre sur Amazon.

Étude à méditer !

Une nouvelle révolution pour les entreprises

Tribune publié sur Le Soleil le 11 novembre 2023

Dans la dernière année, les récentes avancées en matière d’intelligence artificielle générative annoncent une véritable révolution pour les entreprises. Entrevue avec Gaétan Marceau-Caron, directeur de l’équipe de recherche appliquée à Mila, l’institut québécois d’intelligence artificielle.

Q. D’abord, comment peut-on définir l’IA générative?

R. Il s’agit de programmes informatiques qui ont été créés par l’apprentissage automatique sur de vastes quantités de données disponibles sur le Web et qui sont capables de générer de nouvelles données originales comme du texte, des images, de la vidéo et du son. La qualité et le niveau de complexité du contenu généré sont très élevés et ces outils peuvent s’avérer très intéressants dans un contexte d’affaires pour les entreprises.

Q. Qu’apporte-t-elle aux entreprises?

R. Ce que l’on va voir au cours des prochains mois dans les entreprises, c’est une adoption assez naturelle de l’IA et de l’IA générative à travers les suites d’outils qui sont déjà utilisées par les entreprises via Microsoft 365 (Copilot) et Google Workspace (Duet AI), notamment. Avec ces outils, les entreprises peuvent améliorer leur efficacité et automatiser de l’analyse de texte, de la rédaction ou des calculs avec des indications simples. Il sera même possible de combiner les modèles. Par exemple, mettre à profit un outil qui écoute une réunion et transcrit intégralement ce qui a été dit, et qui transmet ensuite ce contenu à un autre modèle qui en fera un résumé exécutif précis. On sauve donc beaucoup de temps et certaines tâches cléricales sont grandement bonifiées.

Q. Pouvez-vous nous donner un aperçu de ce que nous réserve l’avenir?

R. Cette révolution va à la fois changer la manière dont les entreprises traditionnelles travaillent, mais elle va permettre l’émergence rapide d’un écosystème de startups technologiques qui pourront notamment développer plus rapidement des applications basées sur l’IA générative comme base de leurs services. L’IA générative fait aussi émerger de nouvelles capacités au niveau de la recherche scientifique ce qui va entraîner de nouvelles opportunités. Également, les outils de génération de texte, d’images, son et de vidéos, qui sont aujourd’hui impressionnants, feront un autre grand bond en termes de qualité dans les prochaines années. Les assistants virtuels vont aussi grandement s’améliorer.

Q. Quels sont les risques et enjeux de l’IA générative?

R. L’IA générative, c’est en quelque sorte une machine à fiction qui reproduit les biais des données sur lesquelles elle a été entraînée. Par exemple, les outils comme ChatGPT n’ont pas d’esprit critique face aux réponses qu’ils donnent. Il faut donc rester prudent face à leurs résultats. Il faut en outre garder à l’esprit que certains des biais de la société ont été encodés dans ces modèles.

Au niveau de la cybersécurité, c’est majeur. À partir du moment où des informations personnelles ou confidentielles sont partagées à ces modè-les, celles-ci se retrouvent sur des serveurs sur lesquels on n’a aucun contrôle. Mieux vaut être très prudent et être bien conseillé par des experts technologiques et légaux quand on utilise ces outils dans notre entreprise. Finalement, la gouvernance de ces nouveaux modèles doit être une priorité pour nos gouvernements afin que les risques associés à leur utilisation à large échelle soient mitigés. Nous sommes dans une période pivot où l’accélération des innovations en IA se fait très rapidement. L’IA a un potentiel exceptionnel, notamment pour la productivité des entreprises. Nous devons nous assurer de bien encadrer sa gouvernance afin de pouvoir profiter des grandes avancées technologiques, économiques et scientifiques et ce, au bénéfice de tous et toutes.

Article source : L’IA générative : nouvelle révolution pour les entreprise

Publié sur Le Soleil le 11 novembre 2023

Peut-on utiliser des images générées par IA pour son entreprise ?

Ce point juridique est fondamental pour les entreprises

Quelle est la situation juridique actuelle en matière de droit d’auteur sur les images générées par IA ?

En l’absence de règles spécifiques, les règles de droit commun s’appliquent aux créations générées par IA. Or, le droit d’auteur n’exclut pas, par principe, la protection de ces créations.

Une distinction fondamentale doit être faite entre « œuvres générées exclusivement par IA » et « œuvres dont la création a été assistée par IA ». Dans le premier cas, on peut douter du caractère protégeable de ces créations en l’absence de toute intervention humaine, qui rendra impossible la caractérisation de l’originalité (empreinte de la personnalité de l’auteur). Pour les œuvres dont la création a été assistée par IA, il appartiendra à l’auteur de démontrer l’ensemble des interventions humaines ayant conduit à la création finale (précision des prompts et modifications ultérieures du contenu généré par IA [output] pour aboutir à la création finale). Le défi sera ainsi d’ordre probatoire.

Par ailleurs, il conviendra de vérifier les conditions générales du système d’IA utilisé, qui règlementent la question de la titularité du contenu généré. Il est ainsi impératif de s’assurer au préalable d’une propriété totale de l’utilisateur sur l’output, avant toute diffusion d’un contenu généré par IA.

Une entreprise peut-elle utiliser une image générée par IA pour un usage commercial ? Si oui, sous quelles conditions ?

Oui, sauf bien entendu si les conditions applicables au générateur d’images utilisé interdisent un tel usage commercial de l’output, ce qu’il convient de vérifier en amont. Les entreprises restent, a priori, libres de pouvoir faire usage des contenus générés par IA, tout en conservant l’entière responsabilité attachée à la diffusion du contenu.

Que l’usage soit réalisé à des fins commerciales ou non, il appartient à l’entreprise souhaitant faire utilisation du contenu généré par IA de s’assurer du respect des droits de tiers, notamment les droits de propriété intellectuelle (droit d’auteur, marque) ou les droits de la personnalité (l’image, le nom ou la voix).

Avec le projet de règlement européen sur l’IA, qui est encore en cours de discussion, les entreprises faisant un usage d’un contenu généré par IA devront également faire preuve de transparence et informer le public que le contenu diffusé a été généré ou manipulé par un outil d’IA. Il est à noter qu’une telle obligation de transparence existe déjà en France en matière d’influence commerciale, pour les communications comprenant des images représentant des visages ou silhouettes produites par des procédés d’IA.

Les images générées par des systèmes d’IA nourris par des banques d’images, comme Adobe Firefly entraîné sur Adobe Stock, peuvent-elles être utilisées par les entreprises sans risques ?

Le risque zéro n’existe jamais. Une image générée par un système d’IA peut, comme n’importe quelle autre création humaine, porter atteinte à des droits de tiers. C’est pour cette raison qu’il est primordial d’assurer un contrôle sur le contenu généré par IA, afin de limiter les risques de voir la responsabilité de l’entreprise engagée.

Certains fournisseurs d’IA mettent en place des garanties « anti-contrefaçon » qui visent, non pas à assurer l’absence de réclamation de la part de tiers, mais à prévoir une garantie d’indemnisation en cas de réclamation portant sur un contenu généré par IA. Ces garanties sont soumises à des conditions très spécifiques, qu’il convient de vérifier en amont de toute utilisation.

Quels conseils donneriez-vous aux professionnels pour éviter les problèmes de droit d’auteur liés à l’utilisation d’images générées par IA ?

Les conseils à donner en la matière ne sont pas différents de ceux applicables à toute création artistique, ils doivent simplement être appliqués avec davantage de vigueur.

En amont, il convient de veiller à ne pas incorporer au sein des prompts de données personnelles, confidentielles ou stratégiques de l’entreprise, qui pourraient se retrouver incluses dans le contenu final.

Il s’agit, ensuite, de documenter l’ensemble du processus de création, ce qui permettra de justifier de l’existence de droits d’auteur sur la création générée à l’aide d’un système d’IA. Bien entendu aussi, l’IA générative devra être utilisée dans le respect des droits de tiers, afin de limiter le risque de réclamation.

Il importe enfin de ne pas utiliser telle quelle une création générée par IA, sans avoir procédé aux vérifications habituelles de son caractère licite auprès des interlocuteurs juridiques de l’entreprise.

Dans le cadre de votre travail, avez-vous déjà eu des cas concrets de litiges concernant des contenus générés par IA ?

Il n’existe, pour l’instant, pas de jurisprudence rendue en matière d’IA générative en France. Les principaux travaux qui m’ont été confiés pour l’instant concernent un travail préparatoire de formation des entreprises aux problématiques juridiques posées par les systèmes d’IA génératives (directions de la communication et juridique, notamment). J’interviens régulièrement, avec l’appui des autres départements du cabinet, sur la rédaction de chartes internes et de codes de conduite d’entreprise, visant à sensibiliser les collaborateurs aux risques résultant de ces outils et encadrer l’usage de l’IA en interne. L’adaptation des contrats passés avec les prestataires dans le secteur de la création est également un chantier majeur pour les entreprises.

Quelles sont les sanctions encourues en cas d’utilisation non autorisée d’une image générée par IA ?

Les sanctions peuvent concerner la violation de droits de tiers (contrefaçon ou concurrence déloyale/parasitisme) ou le manquement contractuel de l’utilisateur du système d’IA (violation des conditions générales de la plateforme proposant le système d’IA).

Le risque lié à une action en contrefaçon peut conduire à une condamnation à verser des dommages et intérêts au titulaire de droit, au regard du préjudice subi (économique ou moral).

Il existe aussi des sanctions pénales, rarement prononcées, qui peuvent aller jusqu’à 3 ans d’emprisonnement et 300 000 euros d’amende (1 500 000 euros pour les personnes morales).

L’auteur de cette tribune

Pierre Pérot, avocat senior au sein du cabinet August Debouzy

Pierre Pérot évolue au sein de l’équipe Propriété intellectuelle, média et art. Il accompagne des clients sur toutes les questions liées au droit des marques, des dessins et modèles, du droit d’auteur, mais aussi sur l’intelligence artificielle générative, sujet sur lequel il a écrit différents articles. Il est doté d’une solide expérience contentieuse, tant dans le cadre de litiges nationaux que multi-juridictionnels, ainsi qu’auprès des offices français et européens.

Texte source de cette tribune : Peut-on utiliser des images générées par IA pour son entreprise ?

Publiée sur Le Blog du Modérateur le le 13 novembre 2023

Les IA génératives pourraient provoquer un déclin cognitif

Entretien avec Mme Laurence Devillers

Selon la chercheuse Laurence Devillers, les IA génératives ne seraient pas une bonne solution pour développer le sens critique, la créativité, la connaissance chez les élèves, et notamment chez les plus jeunes.

Professeure en IA à l’université Paris-Sorbonne, Laurence Devillers est experte en interactions humain/machine, chercheuse au Laboratoire d’informatique pour la mécanique et les sciences de l’ingénieur (Limsi) du CNRS, et présidente de la Fondation Blaise Pascal de médiation en mathématiques et informatique. Elle est l’autrice de plusieurs livres sur l’IA et le numérique, dont Des robots et des hommes, édité par Plon en 2017, Les Robots émotionnels, paru en 2020 aux éditions de l’Observatoire, et La Souveraineté numérique dans l’après-crise, sorti la même année chez le même éditeur.

Pouvez-vous nous rappeler ce que les IA génératives, et plus particulièrement ChatGPT, la plus connue d’entre elles, sont capables de faire et ce qu’elles ne peuvent pas faire ?

Laurence Devillers : ChatGPT est un cas de figure intéressant, car c’est la technologie la plus aboutie dans ce domaine. Avec GPT3, élaboré à partir de 175 milliards de paramètres, et GPT4, cet « agent conversationnel » a bénéficié d’un modèle de fondation, c’est-à-dire un modèle d’intelligence artificielle de grande taille fonctionnant par apprentissage automatique, qui a été entraîné sur des centaines de milliards de données et de textes de toute sorte provenant d’Internet. De ce fait, cet outil est en mesure de répondre à une question, de rédiger une dissertation, de produire une lettre de recommandation, de traduire un texte, de faire une synthèse, d’élaborer un programme, etc. Il aura bientôt une entrée multimodale et pourra ainsi interpréter une image. Cependant, il ne vérifie pas ce qu’il produit, ce qui fait qu’il n’est pas capable de garantir une réponse fiable à l’utilisateur. Rien n’est prévu en ce sens. Cet outil génère du contenu sans conscience, sans émotion, sans intention préalable… Par ailleurs, il perd les sources qu’il a utilisées lorsqu’il propose une réponse. Il y a donc une marge d’erreur potentiellement importante à chaque utilisation.

Très peu de temps après sa sortie, ChatGPT a fait son apparition dans l’enseignement, aussi bien du côté des élèves que de celui des professeurs… D’un point de vue strictement pédagogique, que peut-il apporter ?

L.D. : Les principaux avantages liés à l’utilisation de cette technologie sont la facilité d’accès à un grand nombre de données en temps réel, simplement et rapidement pour le plus grand nombre. D’un point de vue strictement pédagogique, il peut apporter un apprentissage dédié et personnalisé en fonction des besoins de chaque utilisateur, à condition de pouvoir contrôler la véracité de ce qu’il propose.

Peut-on dire que cet outil fait apparaître une nouvelle façon d’apprendre et d’enseigner ?

L.D. : Les outils numériques et les IA génératives ne sont pas une bonne solution pour développer le sens critique, la créativité, la connaissance, chez les élèves, et notamment chez les plus jeunes. ChatGPT produit à l’occasion des fake news, et il est donc important d’avoir la capacité de faire le tri. Cela veut dire avoir du recul et pouvoir faire preuve de discernement, mais aussi savoir déceler une information erronée. Il faut garder la majorité du temps d’apprentissage pour les méthodes classiques, avec du papier et un crayon, sans prothèses numériques. À partir de quel âge peut-on douter de ce que propose ChatGPT et modifier le contenu sans être manipulé par les réponses du système ? Le problème est crucial pour les élèves et devrait nécessairement questionner les adultes.

Justement, ne faudrait-il pas en priorité apprendre aux élèves et au corps enseignant à se servir de cet outil, ce qui n’est pas le cas actuellement ? De toute évidence, il y a un réel manque de pédagogie et de formation…

L.D. : Oui, en effet. Et c’est une question très importante. Il faudrait que les enfants mais aussi les adultes soient initiés le plus tôt possible aux usages de ces nouvelles IA. Nous manquons de pédagogie et de formation agile pour les professeurs, comme pour les élèves. Et il est urgent de corriger le tir. Dans le cadre de la Fondation Blaise Pascal de médiation en mathématiques et informatique, nous avons conçu, grâce à des mécènes, et notamment la Maif et le CNRS, une douzaine de capsules vidéo de deux à quatre minutes sur le thème de l’éthique dans l’IA, qui ne demandent a priori pas de connaissances sur le sujet aux professeurs pour parler des usages de l’IA en classe, et notamment de ChatGPT… C’est un début, mais il faut aller plus loin.

Pour les élèves, quels sont les risques associés à cette technologie ?

L.D. : Si nous sommes seulement des consommateurs devant les IA telles que ChatGPT, il risque d’y avoir une baisse des capacités d’apprentissage. Ne plus apprendre à écrire, à compter, ne plus apprendre la logique, le raisonnement, les langues, ne nous donnera pas les bases pour remettre en doute ce que propose la machine. Par paresse, nous risquons de suivre uniquement les propositions de ChatGPT, sans chercher par nous-mêmes à réfléchir. Cela pourrait provoquer un déclin cognitif.

Selon vous, est-ce que ce mouvement est inéluctable ? Va-t-on aller vers toujours plus d’intelligence artificielle et un développement toujours plus important d’outils comme ChatGPT ?

L.D. Oui, c’est le cas. Le mouvement vers plus d’IA est inéluctable, et c’est pour cette raison qu’il faut travailler sur l’accompagnement, la formation, l’apprentissage de ces outils, mais aussi sur les réflexions éthiques qu’ils suscitent et les garde-fous que l’on pourrait mettre en place. Nous avons indéniablement besoin de réguler les IA génératives avant de les laisser utiliser par des enfants à l’école. En ouvrant ChatGPT à tous, en le démocratisant, Sam Altman, le CEO d’OpenAI, a réussi un formidable hold-up. Mais, étant donné que ChatGPT fait des erreurs, et que cela est désormais prouvé, saurons-nous les déceler si nous n’apprenons pas les pièges que recèlent ces machines et si les ingénieurs ne soulèvent pas le capot de la voiture pour décortiquer le fonctionnement du moteur ? La régulation doit servir à poser des limites, mais aussi à exiger plus de transparence afin de pouvoir produire une évaluation précise et fiable de cet outil. Elle n’est pas seulement utile pour encadrer l’utilisation de ChatGPT et éviter ainsi de potentielles dérives, elle est en fait indispensable pour s’en servir correctement.

Les IA génératives représentent un phénomène récent dans nos vies. À quoi peut-on s’attendre pour la suite ?

L.D. : La prochaine étape à laquelle nous devons nous préparer est l’arrivée des « robots émotionnels », une nouvelle génération d’IA qui sera capable de prendre en considération nos émotions grâce à l’analyse de notre visage, à l’interprétation de nos gestes, de nos postures… Ces machines existent déjà, à l’instar des robots Pepper, Nao et Buddy, pour aider les enfants à renforcer leur confiance en eux et leurs compétences sociales, mais elles n’en sont encore qu’à un stade limité de développement. Demain, les robots émotionnels pourront détecter nos peurs, nos angoisses, nos tristesses, et seront programmés pour nous assister et nous réconforter. Ce seront nos anges gardiens numériques. En matière d’éducation, de la même manière, ces machines seront capables d’épauler un élève en difficulté, de l’aider à surmonter un obstacle ou à résoudre un problème. Mais il faut se méfier, car il y aura un contrecoup… : dépendance affective, isolement, perte de liberté, amplification des stéréotypes et des risques réels de manipulation. Il faudra nécessairement mettre l’éthique au cœur du fonctionnement de ces nouvelles IA et exercer un contrôle sur leur utilisation.

Texte source : Les IA génératives pourraient provoquer un déclin cognitif

Publié sur L’ADN par Arnaud Pagès le 13 novembre 2023

Les accros à chatGPT

ChatGPT est arrivé dans nos vies il y a tout juste deux ans. Depuis, beaucoup de français s’y sont mis. Si la plupart l’utilisent une fois de temps au bureau, pour écrire un mail ou un traduire un texte certains ont un recours beaucoup plus personnel à chatGPT jusque dans leur vie intime

Stéphane Jourdain bonjour… Vous avez rencontré des Français qui l’utilisent pour des tâches de tous les jours qu’on aurait jamais imaginé confier à une intelligence artificielle…

Plan de cette chronique :

- Une leçon de chatGPT sur les métropoles…

- Des relations qui peuvent être encore plus personnelles

- « La machine est programmée, elle nous donne un savoir déterminé, elle ne nous surprend pas »

Tribune à lire : Les accros à chatGPT publié sur France Inter le vendredi 29 novembre 2024