L’IA dans l’art aujourd’hui : le meilleur des faussaires

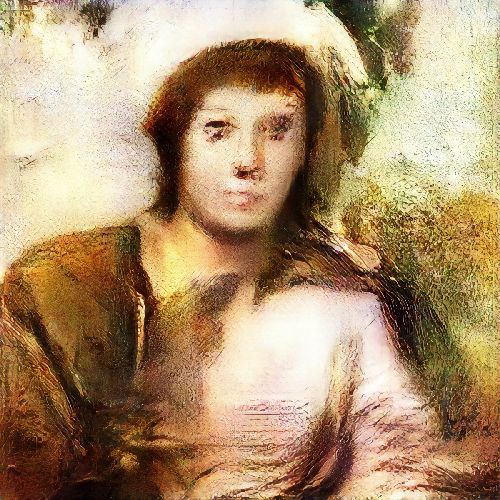

L’intelligence artificielle étonne aujourd’hui par ses capacités à s’inspirer d’œuvres d’art pour en créer des nouvelles, et ce, dans tous les domaines artistiques. Des sculptures cybernétiques de Nicolas Schöffer au « Portrait d’Edmond de Bellamy », première œuvre réalisée par l’IA à être mise en vente aux enchères, en passant par le titre « Daddy’s car » écrit par le système FlowMachines de Sony ou encore la rédaction récente d’articles pour The Guardian, les prouesses de l’IA surprennent et troublent. Les expositions-expériences basées sur l’IA foisonnent et il est fort probable que nous voyions apparaître, dans un futur proche, des peintures ou des romans adaptatifs, interagissant avec le visiteur en fonction de son humeur ou de son comportement. De nombreux outils informatiques émergent aujourd’hui. Disponibles dans le Cloud et bientôt à la portée de tous, ils ouvrent de nouveaux champs artistiques basés sur l’IA.

L’IA ne connaît pas le syndrome de la feuille blanche et multiplie les propositions artistiques, qu’elle parvient en outre à créer en un temps record. Comment est-ce possible ? Tout simplement parce que l’IA appliquée à l’art repose sur les techniques de machine learning et de deep learning, c’est-à-dire sur des méthodes d’apprentissage automatique à partir de l’absorption massive de données, dont des milliers d’œuvres issues de l’histoire de l’art.

Ce que produit l’IA remet en cause notre jugement sur la qualité d’une œuvre et interroge notre rapport au « beau universel », car même un amateur d’art averti a du mal à distinguer les œuvres créées par des êtres humains de celles produites par des algorithmes. Se posent alors les questions du statut d’auteur d’une machine, de son génie créatif, de la valeur des productions… mais aussi de son avenir. Car si la machine s’inspire d’œuvres existantes pour en créer de nouvelles, ne risque-t-elle pas de « tourner en rond » au bout d’un moment ? Est-elle capable d’un réel acte créatif ? Et surtout, peut-elle s’émouvoir ? Aujourd’hui la réponse est non, car la voie technologique de l’apprentissage automatique ne permet que de reproduire sans conscience des comportements humains et non pas d’octroyer à l’IA une capacité créative propre.

L’innovation ultime serait-elle d’amener l’IA à sortir de la technologie ?

Depuis plusieurs années maintenant, les applications d’IA se sont immiscées dans nos vies et dans notre quotidien, sans pour autant interroger nos sens. Est-ce là une voie d’exploration technologique de demain, en particulier dans l’art ? Sans doute ! Car les technologies basées sur le machine et le deep learning ont déjà près de 30 ans et n’ont plus rien de révolutionnaire. Il est temps d’élargir les perspectives, en s’appuyant sur les autres découvertes en sciences cognitives, en neurosciences et en psychologie humaine. L’avenir de l’intelligence artificielle dépendra des avancées dans ces domaines précis.

Différentes études explorent ces pistes-là, par exemple autour de la programmation probabiliste. En ne s’appuyant pas uniquement sur des bases de données, elles tentent de générer créativité et émotion autrement. Ces travaux n’en sont encore qu’à leurs prémices, mais ils ouvrent une brèche à des perspectives aussi étendues qu’exaltantes. L’IA pourra-t-elle doter les machines d’un sens commun et leur permettre de ressentir et de transmettre des émotions ? La question n’est pas tellement de savoir si cela va arriver, mais plutôt quand cela va arriver !

L’intelligence humaine n’est pas uniquement une bibliothèque de connaissances, elle regorge de subtilités sensorielles et émotionnelles que le contact avec l’art pourrait activer. C’est finalement l’art qui, par sa capacité à questionner les chercheurs, nourrit la science et est moteur pour l’innovation, et non pas l’inverse. L’art s’impose comme un catalyseur pour la recherche et transcende les scientifiques. L’avenir s’annonce révolutionnaire en la matière. Aujourd’hui, une intelligence artificielle peut créer et lire un poème. Demain, elle pourra s’en émouvoir.

Texte publié sur Forbes par David Bégasse le 28 avril 2021