Pas trop de blabla dans cette partie , vive les exemples !

Pour les réseaux sociaux, lutter contre la désinformation est devenu une priorité. À l’occasion de l’élection présidentielle américaine, ce sujet était dans toutes les têtes et les plateformes se sont activées pour trouver des solutions. Twitter et Facebook ont notamment décidé d’utiliser un système d’étiquettes qui permet d’informer les utilisateurs lorsqu’ils s’apprêtent à interagir avec une publication jugée contestable, voire fausse.

Des chercheurs du MIT on justement planché sur ces étiquettes de vérification de faits afin de mieux évaluer leur efficacité. Les résultants ont surpris les scientifiques puisqu’ils ont constaté que ces avertissements sont plus efficaces une fois que les internautes ont pris connaissance des titres plutôt qu’avant.

Dans le détail, les scientifiques ont mené leur expérience sur un total de 2683 personnes qui ont examiné 18 vrais titres d’informations et 18 fakes news qui avaient été vérifiées par le site spécialisé Snopes.com. Ensuite, les participants ont vu les étiquettes, avant, pendant, ou après la lecture de ces 36 titres.

Le résultat est assez net puisque la mauvaise interprétation d’une information était réduite de 25,3 % lorsque l’utilisateur prenait connaissance de l’étiquette après avoir lu les titres. Cette baisse était plus limitée lorsqu’ils en avaient pris connaissance avant : 5,7 %, ou pendant : 8,6 %.

David Rand, un des auteurs, explique à ce sujet : « En entrant dans le projet, j’avais prévu qu’il serait préférable de donner la correction à l’avance, de sorte que les gens ne croient pas l’information lors de sa lecture. À ma grande surprise, nous avons en fait trouvé l’inverse. Démystifier l’affirmation après qu’ils y ont été exposés était le plus efficace. »

Cette étude représente plutôt une bonne nouvelle dans la lutte contre ce phénomène. Les internautes sont bien confrontés aux fausses nouvelles, mais cela démontre qu’ils sont aussi prêt à les remettre en question et à croire les outils de vérifications de faits.

Pour la suite, les chercheurs estiment que « s’il n’y a pas de solution miracle pour lutter contre la désinformation », les plateformes et les fournisseurs de contenus doivent prendre en compte ces résultats lors de la conception de leurs outils.

Article : Ces chercheurs du MIT proposent une nouvelle méthode pour lutter contre les fake news

Publié sur Presse Citron le 6 mars 2021

par Jean-Yves Alric

Voici un montage qui ne manque pas d’humour. Ce mardi 23 mars 2021, les experts, artistes, créateurs de contenus et personnalités qui participent au mouvement #OnEstPrêt ont partagé une vidéo hilarante et engagée baptisée.

Réalisée avec trucage, elle met en scène Emmanuel Macron au beau milieu d’une forêt, un sac plastique à la main. Pendant près de deux minutes, le chef d’État revient sur la Convention Citoyenne pour le Climat et explique pourquoi il ne fera rien pour notre planète.

Évidemment, il s’agit d’un enregistrement vidéo et audio réalisé grâce à l’intelligence artificielle.

Ces mots n’ont donc pas été prononcés par Emmanuel Macron, mais ils ont le mérite d’attirer notre attention. En effet, l’idée est d’inviter l’ensemble des citoyens à demander une vraie loi Climat, et non pas à renier cette dernière.

Utilisée au cinéma la plupart du temps, le deepfake est une technologie qui permet, grâce à une série d’algorithmes, de superposer sur la tête d’un figurant le visage d’une autre personne, souvent une célébrité. Dans « Rogue One : A Star Wars Story », les réalisateurs ont eu recours au deepfake pour faire « revivre » l’acteur Peter Cushing dans le film.

C’est donc le même genre de prouesses technologiques que réalise le compte TikTok « deeptomcruise ». Depuis une dizaine de jours, il cartonne sur TikTok avec de fausses vidéos de l’acteur Tom Cruise. L’illusion est largement réussie, et les internautes n’en reviennent pas. Le premier deepfake de Tom Cruise a d’ailleurs été vu plus de 10 millions de fois.

Pour admirer le résultat : Un Belge cartonne sur TikTok avec ses vidéos deepfake de Tom Cruise

Publié sur SoirMag le 6 mars 2021

Des chercheurs de l’université de Washington ont démontré qu’une Intelligence artificielle était capable de modifier les images satellites et de transformer l’apparence des rues et des paysages d’une ville. Une manière, selon eux, de prouver qu’il faut anticiper la possibilité par des personnes mal intentionnées de manipuler des photos aériennes.

Au delà de l’exploit « soit disant scientifique » ; ceci pose des problèmes de fonds très important ! En effet, de fausses images satellites pourraient avoir des conséquences désastreuses dans de nombreux domaines.

Bo Zhao explique notamment que la modification d’une image satellite pourrait lourdement impacter les tactiques militaires, et même participer à la propagation de fake news. Les fausses images pourraient être utilisées pour couvrir des activités illicites ou contredire des informations officielles. Avec son étude, l’équipe explique aux médias américains vouloir “démystifier la fiabilité absolue des images satellitaires et de sensibiliser le public à l’influence potentielle de la deepfake géographie”.

Cette équipe de chercheurs a formé l’IA avec des images satellites de trois villes différentes : Seattle, Tacoma et Beijing. Vue du ciel, chacune a une apparence différente en fonction du tracé des rues, de la verdure, mais aussi de la largeur des artères ou encore simplement de la couleur des bâtiments et des ombres.

Résultat, l’IA est capable de donner l’aspect de Pékin à Seattle, et vice-versa. En zoomant, il est possible de voir des incohérences, mais comme pour le « deepfake », le premier coup d’œil est trompeur, et qui va creuser pour savoir qu’une image est fausse ? Selon ces chercheurs, cette technique pourrait être utilisée pour simuler des images de lieux pour lesquels aucune image satellite n’est disponible mais aussi par des climato-sceptiques pour démontrer que le réchauffement climatique n’est qu’une illusion…

Ce qui est plus intéressant, en revanche, c’est la possibilité de donner vie à d’anciens plans dessinés à la main il y a plusieurs siècles.

Sources anglophones :

Sources francophones :

Voir aussi notre dossier : IA dans la défense

En écho à l’article précédent ! un exemple réel.

Article source : Beijing Takes Its South China Sea Strategy to the Himalayas

Publié sur The New York Times le 19 février 2021 par Steven Lee Myers

« https://korii.slate.fr/et-caetera/internaute-trafique-carte-open-source-openstreetmap-faveur-chine-bhoutan

L’idée de faire un featuring avec des célébrités a titillé l’esprit de nombreux chanteurs amateurs. Ce projet pourrait devenir possible sans l’accord de l’intéressé et sans sortir de chez soi en créant… un deepfake audio de ce dernier.

Concrètement, l’IA Uberduck permet ainsi de choisir la voix d’une star de la musique puis de saisir le texte qu’elle doit prononcer. L’imitation est plutôt convaincante (mais pas toujours) et ce dispositif est très simple d’utilisation.

La liste des stars proposées est assez impressionnante et cela va de Tupac, Jay-Z, Eminem, Kanye West, en passant par Michael Jackson, ou encore Rick Astley. Des voix de personnages fictifs sont aussi proposées à l’image d’Eric Cartman, Mickey Mouse, ou maître Yoda.

Cité par The Next Web, le créateur d’Uberduck explique : « J’ai construit un chatbot audio interactif sur WebRTC qui générait des réponses textuelles avec un modèle Transformer et les synthétisait en audio, mais j’ai trouvé que la synthèse vocale était la partie la plus excitante du projet. »

Très vite, son outil cartonne sur TikTok avant d’être retiré suite à une action en justice. Il reste toutefois disponible en accès libre. Lors de notre essai, nous avons pu constater que certaines imitations sont plus réussies que d’autres et on peut aussi voir que des paroles sont mieux adaptées à certains débits de parole.

Comme le font nos confrères, on peut aussi se poser la question des potentielles dérives autour de cet outil, tels que la désinformation. Dans ses conditions d’utilisation, Uberduck interdit toutefois d’utiliser les sons à des fins commerciales, ou les productions à caractère diffamatoire.

Lors de leur diffusion, les internautes doivent aussi clairement préciser que ces productions ont été générées par une intelligence artificielle, sous peine de bannissement. Enfin, si des personnalités en font la demande, leurs voix seront immédiatement retirées du site.

L’interface, dans une page Web est simplissime…donc je ne la décrit pas !

Trouvez ce petit truc sur jeuxvideo.com :

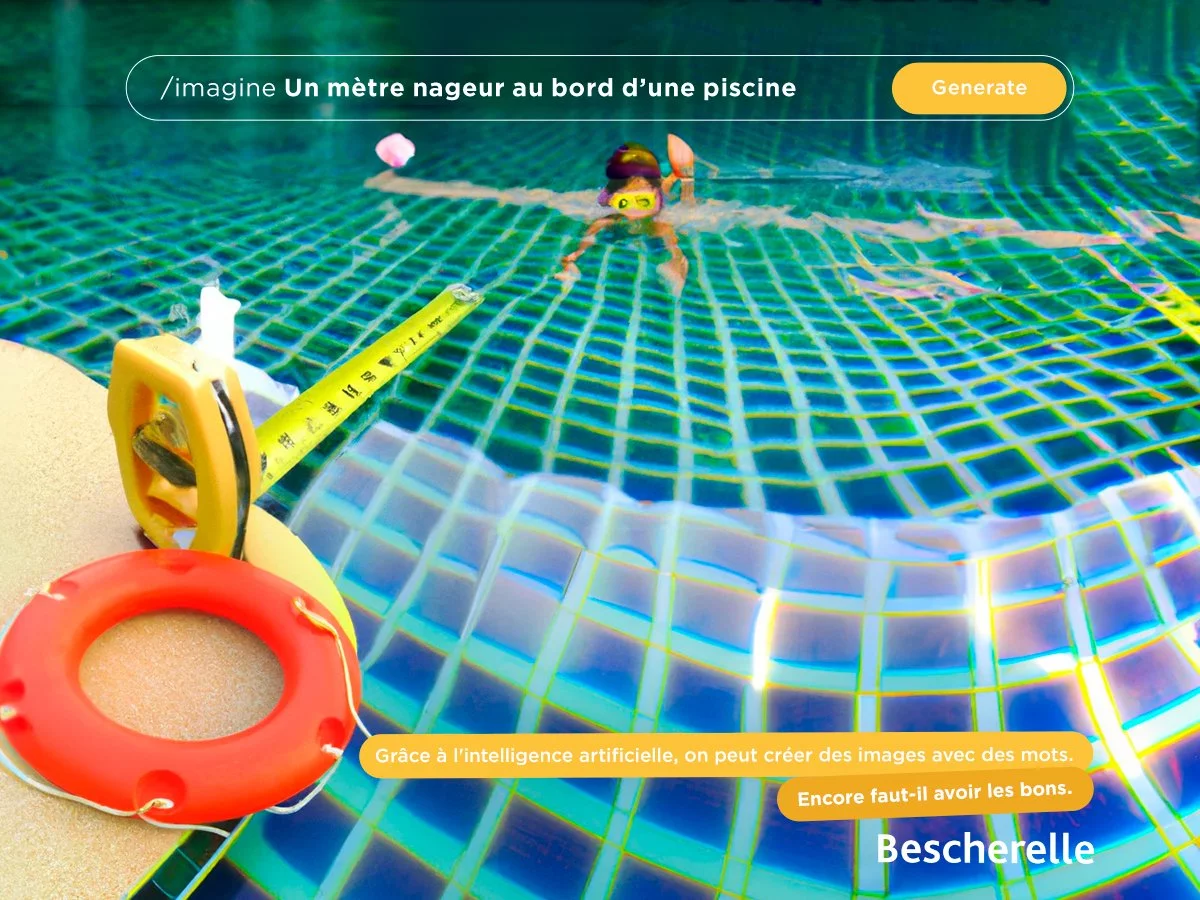

Sur Internet, nous retrouvons différents outils d’imagerie alimentés par des intelligences artificielles. DALL-E, l’une des plus populaires, est d’ailleurs particulièrement plébiscité dans le milieu du jeu vidéo. Et quand on mixe des célébrités à des univers vidéoludiques, il faut avouer que le résultat est quelque peu déroutant.

Les outils d’intelligence artificielle deviennent de plus en plus populaires au sein des différentes communautés du paysage vidéoludique. Comme nous vous l’expliquions plus haut, avec l’aide de l’outil DALL-E, qui, grâce à une intelligence artificielle, génère des images abstraites à partir de quelques mots, nous transformons des personnes célèbres et des personnalités fictives en personnages de jeu vidéo.

Regardez :

Plus de détails sur : Cette IA transforme Zerator, Emmanuel Macron et Elon Musk en personnage de jeu vidéo et c’est très drôle !

Publié sur JeuxVideo.com le 01 septembre 2022

Tom Cruise lance la campagne électorale :

Il y a quelques mois, l’acteur américain Tom Cruise a lancé son compte TikTok, sous le pseudonyme @deeptomcruise.

L’acteur de 58 ans a posté diverses vidéos, permettant notamment d’admirer son swing sur un parcours de golf, ou encore un petit tour de magie, le tout avec la gestuelle si caractéristique, de Tom Cruise évidemment.

Dans chacune des vidéos, on dirait bel et bien que l’on observe “le vrai” Tom Cruise à l’écran, mais en réalité, il n’en est rien…

Pour plus de fakes allez sur : Tom Cruise se lance sur TikTok… mais ce n’est pas “le vrai” Tom Cruise (et ça fait peur)

Je sais, ce n’est pas un Deep Fake, les lords sont trop mignons…

Au Royaume-Uni, les parlementaires de la chambre haute (les Lords) étaient réunis ce 11 octobre 2022 pour discuter de l’influence de l’intelligence artificielle sur les arts. Ils ont interrogé à ce sujet Ai-Da, robot humanoïde aux traits féminins, dans un moment digne d’une scène de science-fiction.

Son nom est Ai-Da : un hommage à la Britannique Ada Lovelace, pionnière des sciences informatiques, mais aussi un clin d’œil à son créateur, Aidan Meller, à la tête d’une galerie d’art à Oxford. Ce robot humanoïde aux traits féminins était convié, mardi 11 octobre, à la Chambre des lords de Westminster : c’est “la première fois qu’un robot prend la parole” lors d’une session parlementaire au Royaume-Uni…

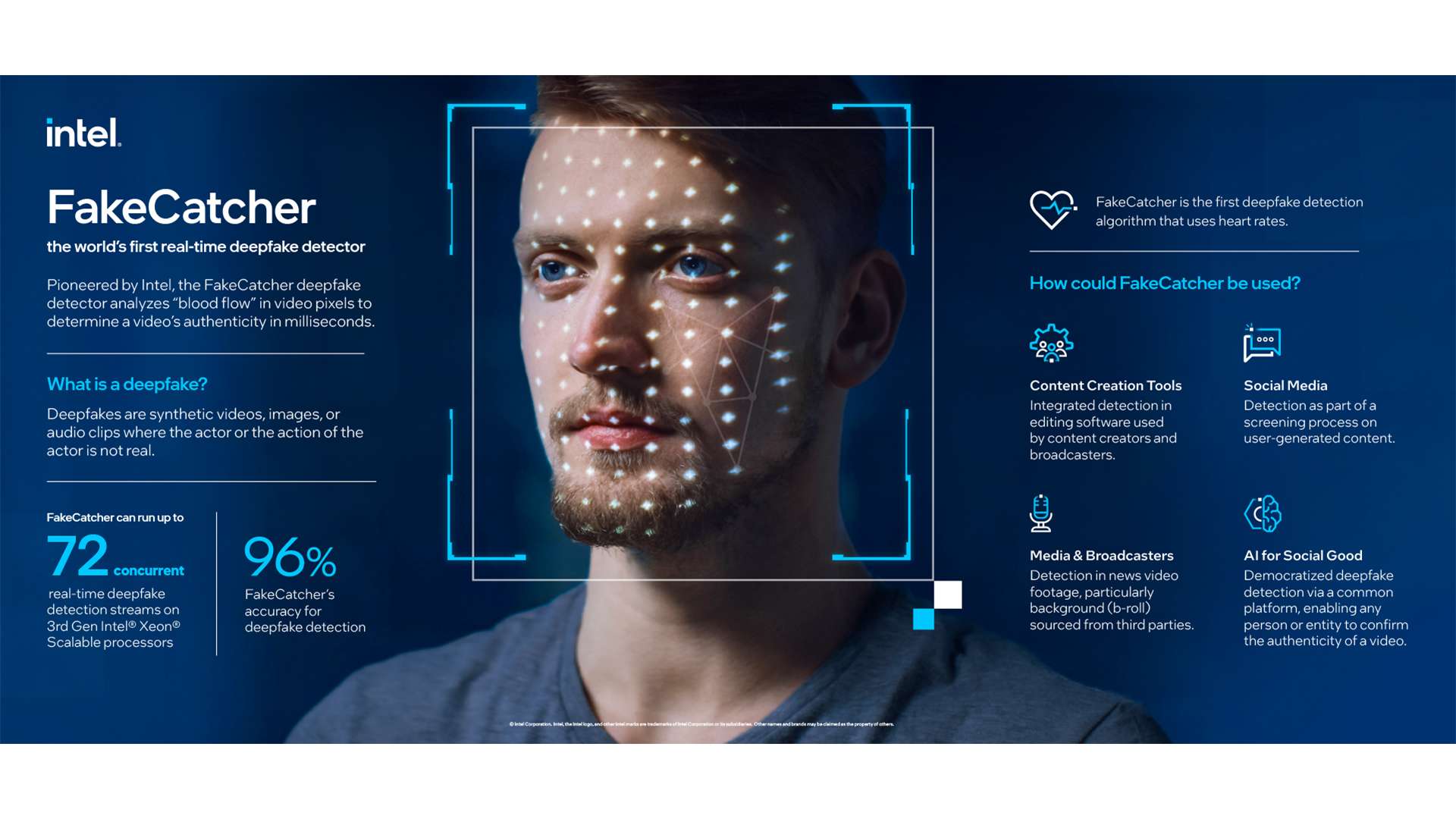

Intel a mis au point FakeCatcher, un outil qui permet d’identifier les deepfakes vidéo avec un taux de réussite de 96 %. Pour savoir s’il s’agit d’un faux, l’algorithme parvient à repérer les subtiles différences de lumière générées par les réseaux sanguins du visage de la personne.

Si elles pullulent de plus en plus sur le Web, les deepfakes de célébrités ou d’anonymes sont nombreuses et deviennent inquiétantes. On a pu voir des clones de Tom Cruise, Elon Musk, Mark Zuckerberg, ou encore Leonardo DiCaprio. Des séquences vidéo sur lesquelles on fait dire n’importe quoi à ces personnalités. Il y a eu cette année aussi un deepfake montrant le président ukrainien Volodymyr Zelensky ordonnant aux troupes du pays de se rendre à la Russie dans un discours peu crédible (voir les exemples en début de page).

Globalement, outre quelques tentatives assez visibles de manipulation, la plupart des exemples sont des parodies amusantes ou des expériences pour chercher à améliorer la technologie. Mais si les premières vagues de deepfakes donnaient le sentiment que quelque chose clochait, les derniers progrès de cette technologie ont de quoi effrayer.

Intel a planché sur la question et vient de dévoiler, en début de novembre 2022, FakeCatcher. Il s’agirait du premier détecteur de deepfakes en temps réel. L’entreprise affirme que cette solution réalisée avec l’Université d’État de New York à Binghamton aux États-Unis, dispose d’un taux de précision de 96 %.

C’est une première !

Les deepfakes utilisent une technologie impressionnante dérivée de l’apprentissage automatique et de l’intelligence artificielle pour créer des images et des vidéos d’une précision effrayante de célébrités et de politiciens faisant et disant des choses qu’ils n’ont pas dites.

Il est de plus en plus important de disposer d’un logiciel pour nous aider à identifier les deepfakes.

Dans le passé, des escrocs ont utilisé des deepfakes pour se faire passer pour des demandeurs d’emploi afin d’accéder à des informations sensibles sur des entreprises. Ils ont également été utilisés pour usurper l’identité de personnalités politiques de premier plan afin de tenir des propos incendiaires.

Surtout que la plupart des gens font défiler leur fil Twitter sans réfléchir et ne prennent pas le temps de vérifier si une vidéo est vraie ou fausse. Et lorsqu’un deepfake obtient des millions de partages, il est bien trop tard.

Lien Intel : Intel Introduces Real-Time Deepfake Detector

Un anglais simple, compréhensible par tous, sur demande j’effectuerai une traduction en français.

Lire également : Sauriez-vous dire lequel de ces 2 visages a été généré par une IA ?

Publié sur Numerama par Aurore Gayte le 28 novembre 2021

Dans un documentaire de BBC Two sur les manifestations de 2019 à Hong Kong, le visage de plusieurs intervenants a été modifié grâce à une intelligence artificielle. Le but : empêcher l’identification biométrique de ces personnes par les autorités chinoises.

Le procédé risque de faire débat. Le magazine britannique New Scientist rapporte que la BBC a recouru à une intelligence artificielle pour retoucher certaines scènes de son documentaire Hong Kong’s Fight for Freedom (“Le Combat de Hong Kong pour la liberté”) et ainsi préserver l’anonymat de plusieurs intervenants.

Article complet : La BBC recourt à des “deepfakes” pour protéger l’anonymat de personnes interviewées

Publié sur Courrier International le 25 novembre 2022

Source : BBC documentary used face-swapping AI to hide protesters’ identities

Publié sur New Scientist le 24 novembre 2022

Lire également :

ndlr : Je voulais écrire un petit article sur ce sujet mais ceci m’en dissuade :

Les deepfake porn, montages mettant en scène une personne dans des vidéos ou des photos pornographiques, ont envahi les réseaux sociaux. Et les femmes sont les premières victimes de ces cyber-délits, qui peinent encore à être punis.

« Je suis fatiguée et il est temps que je vous explique ». Fin octobre, la streameuse Maghla pointait dans un long thread Twitter toute la violence qu’elle subit en tant que femme active (et médiatiquement exposée) sur le service de streaming vidéo Twitch. Cyberharcèlement de masse et dickpics non sollicitées font ainsi partie de son quotidien.

Mais son cauchemar ne s’arrête pas là : Maghla dénonçait au détour de l’un de ses tweets la manipulation de son image à des fins pornographiques. « Il y a des montages sur des corps d’actrices porno », écrit-elle, précisant qu’elle n’est pas la seule femme visée par ces trucages. « Il y a des discords dédiés [des espaces de messagerie instantanée sur le serveur Discord ; ndlr] aux faux ’nudes’ et des mecs qui se br*nlent sur les streameuses avec partages de captures d’écran de lives et des faux montages ».

Maghla se dit victime de deepfake porn, véritable fléau apparu sur le web ces dernières années. Si sa définition juridique reste floue, le deepfake est, selon Laure Landes-Gronowski, avocate spécialisée dans le droit des technologies de l’information et de la protection des données personnelles, contactée par Terrafemina, « l’utilisation d’images, de vidéos ou de données d’une personne, pour en faire un montage quel qu’il soit, généralement à l’aide de logiciels d’intelligence artificielle, pour que cela paraisse le plus réel possible ». Selon elle, les deep fakes porn sont donc « des deepfakes à caractère pornographique ».

Une étude publiée en 2019 par la société de détection des fraudes Sensity AI révélait que 96% de tous les deepfakes en ligne étaient des clips pornographiques ciblant les femmes, et prédisait que ce nombre « continuerait à grandir si aucune action décisive n’est prise ».

Mais la multiplication de ces cyber-délits paraît malheureusement difficile à endiguer, d’autant qu’ils sont extrêmement faciles à commettre. « Ce sont des pratiques qui ont vocation à s’accentuer du fait du développement des technologies, de la maîtrise par des internautes lambdas de ces technologies, et de la protection de leur anonymat », analyse Laure Landes-Gronowski.

Preuve en est : il suffit de taper « deepfakes porn » sur un moteur de recherche pour voir s’afficher dès les premiers résultats une flopée de sites répertoriant de nombreux montages pornographiques…

En France, plusieurs textes peuvent être saisis pour punir le deepfake porn. L’article 226-8 du code pénal précise qu’est « puni d’un an d’emprisonnement et de 15 000 euros d’amende le fait de publier, par quelque voie que ce soit, le montage réalisé avec les paroles ou l’image d’une personne sans son consentement, s’il n’apparaît pas à l’évidence qu’il s’agit d’un montage ou s’il n’en est pas expressément fait mention ».

« On peut invoquer l’article 226-4-1 du code pénal, relatif à l’usurpation d’identité, qui est puni d’un an d’emprisonnement et de 15 000 euros d’amende », indique Sylvie Jonas, avocate experte dans la prévention et la gestion de la cybercriminalité.

Si les deepfakes porn peuvent être punis par la loi, dans les faits, il peut être extrêmement compliqué de remonter jusqu’à leurs auteurs. Lorsqu’ils sont partagés sur les réseaux sociaux, ces trucages pornographiques circulent extrêmement rapidement et humilient les victimes à grande échelle, sans qu’elles ne puissent être certaines que ces montages ont été totalement effacés d’Internet.

L’article 6 de la loi pour la confiance dans l’économie numérique (dite « LCEN ») précise néanmoins que les hébergeurs (des plateformes comme Facebook, Instagram, mais aussi Reddit et Discord, où les deepfakes s’échangent facilement) ont la responsabilité de retirer ou de rendre impossible « promptement » l’accès à ces montages dès lors qu’ils en ont connaissance, et l’obligation de proposer à leurs utilisateur·ice·s des manières de signaler ces comportements.

Le mot « promptement » fait tiquer Sylvie Jonas. « Travailler sur les fameux délais dont disposent les plateformes, pourquoi pas en communiquant davantage sur le sujet, pourrait permettre d’accélérer la prise en charge des victimes », suggère l’avocate.

Article source : Le fléau des deepfakes porn, ces montages obscènes qui pullulent sur le Net

Publié sur HuffingPost le 3 décembre 2022 par Maïlis Rey-Bethbeder en collaboration avec terrafemina

To all my friends in Congress — especially @SenSchumer — thank you!

— Fake Zuck (@DeepFakeZuck) November 29, 2022

Once again, you've kept up your side of the bargain by holding up new laws that would hold Big Tech companies like mine accountable. #FakeZuck pic.twitter.com/8zXm5gNNiP

G

Les activistes se sont servis du visage de Mark Zuckerberg en représailles pour une vidéo truquée où Nancy Pelosi semblait avoir du mal à articuler, et qui avait fait le tour des réseaux sociaux en 2019.

Facebook avait alors refusé de la retirer. Cette publicité espère inciter les deux politiques à accélérer le vote sur deux lois antitrust au Congrès, l’American Innovation and Choice Online Act et l’Open App Markets Act.

Les démocrates n’ont plus beaucoup de temps, car au mois de janvier, le Congrès passera à une majorité républicaine, qui a déjà indiqué qu’ils ne comptent pas approuver ces projets de loi.

Avouez que c’est très bien réalisé !

Impossible de rester de insensible !

Après cinq ans d’absence, le groupe français Phoenix est de retour avec un clip irrésistible – une improbable galerie de peintures mythiques de l’histoire de l’art, qui chantent et dodelinent de la tête, au rythme d’Alpha Zulu, leur dernier titre. Animés par des applications telles que Reface ou Prequel, ces détournements d’œuvres à haut potentiel viral font fureur sur TikTok et Instagram.

Lire aussi : Comment l’appel du 18 juin du général de Gaulle a été reconstitué grâce à l’intelligence artificielle

Publié sur Radio France – France Inter Par Julien Baldacchino, Amélie Perrier le 19 janvier 2023