Dans cette partie nous allons faire connaissance avec les personnages scientifiques qui ont marqués le domaine de l’IA. Cette sélection est personnel donc subjective et loin d’être complète.

Comment s’écrit l’Intelligence Artificielle ?

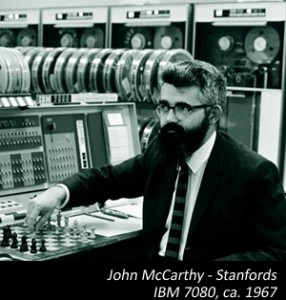

LISP… sous la plume de John Mc Carthy

Sa fiche Wikipédia : John McCarthy

Sa bio rapide : Bio de John McCarthy

John McCarthy, né le 4 septembre 1927 et mort le 24 octobre 2011, était un scientifique informatique et cognitif. Il a inventé le terme « Intelligence Artificielle », a crée le langage de programmation Lisp, a influencé le langage ALGOL et a ainsi était au centre du développement de l’informatique et de l’Intelligence Artificielle.

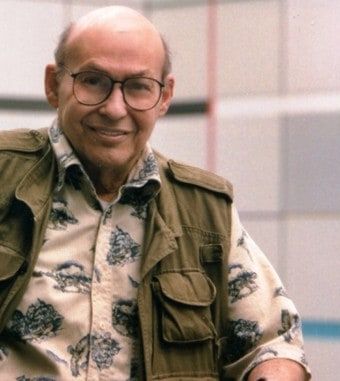

En 2013, Marvin Minsky faisait partie des quelques experts de renommée mondiale invités à New York, aux États-Unis, pour le congrès Global Future 2045 par le multimillionnaire russe Dmitry Itskov. Né en 1927 dans cette même ville d’un père chirurgien spécialisé en ophtalmologie, il était présent en tant que l’un des principaux pionniers de l’intelligence artificielle au XXe siècle.

Sa fiche wikipédia : Marvin Minsky

Distinction : Prix Alan Turing (1969)

Trois vidéo :

Ingénieur et informaticien franco-américain né en , spécialisé dans l’intelligence artificielle. Il est l’un des concepteurs de l’assistant vocal Siri et est depuis 2012 vice-président chargé de l’innovation chez Samsung. Il dirige également le Laboratoire d’intelligence artificielle de Samsung (SAIL) à Paris depuis 2018.

Luc Julia vient de prendre la tête de la stratégie technologique de Renault ; vous pouvez aussi lire son interview sur Capital : En soit l’intelligence artificielle n’est ni bonne, ni mauvaise. C’est juste un outil, comme un marteau.

Voir la critique de son ouvrage « L’intelligence artificielle n’existe pas » dans notre page bibliographie.

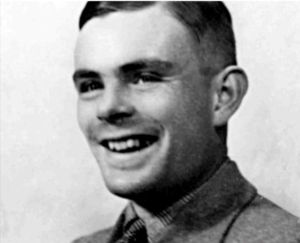

Né le à Londres et mort le à Wilmslow, est un mathématicien et cryptologue britannique, auteur de travaux qui fondent scientifiquement l’informatique. Pour résoudre le problème fondamental de la décidabilité en arithmétique, il présente en 1936 une expérience de pensée que l’on nommera ensuite machine de Turing et des concepts de programme et de programmation, qui prendront tout leur sens avec la diffusion des ordinateurs, dans la seconde moitié du XXe siècle.

Sa fiche Wikipédia : Alan Turing

Conseil personnel : regarder le film Imitation Game

Un excellent film sur l’activité d’Alan Turing pendant la seconde guerre mondiale et les prémices de ce que l’on finira par appeler un ordinateur.

Né le est un chercheur en intelligence artificielle et vision artificielle. Il est considéré comme l’un des inventeurs de l’apprentissage profond. Il reçoit le prix Turing le , partagé avec Yoshua Bengio et Geoffrey Hinton.Y ann Le Cun travaille depuis les années 1980 sur l’apprentissage automatique (machine learning) et l’apprentissage profond (deep learning) : la capacité d’un ordinateur à reconnaître des représentations (images, textes, vidéos, sons) à force de les lui montrer, de très nombreuses fois. ..

Après plusieurs universités et entreprise il est actuellement responsable de la division IA de Meta (Facebook).

Une interview à lire : Yann LeCun (Meta) explore la frontière énergétique de l’apprentissage profond

A computer scientist most noted for his work in the field of artificial intelligence, deep learning and artificial neural networks. He is a co-director of the Dalle Molle Institute for Artificial Intelligence Research in Manno, in the district of Lugano, in Ticino in southern Switzerland.

Lire : l’étoile de l’intelligence artificielle

Publié sur Le Temps le 5 juin 2020 par Andrée-Marie Dussault

En 2005 elle est recrutée comme chargée de recherche CNRS au sein de l’Unité mixte de physique CNRS/Thales. Depuis 2015, elle y est directrice de recherche. Elle participe au projet cerveau humain, rassemblant 87 groupes de recherche qui cherchent à simuler un cerveau humain par le recours notamment à de l’électronique et de l’informatique.Elle a démontré en 2017 qu’un nano-neurone artificiel pouvait reconnaître des chiffres prononcés, les résultats furent publiés dans la revue Nature

Sa présentation par le CNRS : Julie Grollier, chercheuse (bio)inspirée

Un article à son sujet : la physicienne qui crée des neurones artificiels publié sur Le Monde

Sa fiche Wikipédia : Julie Grollier

Irina Rish est professeure agrégée au Département d’informatique et de recherche opérationnelle de l’Université de Montréal (UdeM) et membre clé de Mila – Institut québécois d’intelligence artificielle. Elle est titulaire de la Chaire en IA CIFAR-Canada et de la Chaire d’excellence en recherche du Canada en IA autonome. Elle est titulaire d’une maîtrise et d’un doctorat en IA de l’Université de Californie, Irvine, et d’une maîtrise en mathématiques appliquées de l’Institut Gubkin de Moscou. Ses recherches portent sur l’apprentissage machine, l’analyse des données neurales et l’IA inspirée des neurosciences.

Elle est détentrice de 64 brevets et a fait une longue carrière chez IBM avant de choisir Montréal pour y poursuivre ses travaux. Irina Rish, originaire de ce qui est aujourd’hui l’Ouzbékistan, dirigera l’automne prochain une chaire de recherche dotée d’un imposant budget de 34 millions afin d’approfondir les liens entre le cerveau humain et l’intelligence artificielle

Est un ingénieur et chercheur en intelligence artificielle français ; diplômé de l’ENSTA Paris, il travaille pour Google oû, il a développé la bibliothèque libre Keras d’apprentissage profond et l’auteur de l’ouvrage Deep learning with Python (L’apprentissage Profond avec Python, a voir sur la page Bibligraphie).

En une dizaine d’années, M. Chollet, est devenu un des pontes du Deep Learning !

Son site personnel : François Chollet

Sa fiche Wikipédia : François Chollet

Avec à son actif les succès passés et récent d’AMD ou les premières puces A de chez Apple, Jim Keller est un monument du monde des processeurs. Aussi, quand il quitte Intel pour une entreprise inconnue dédiée aux processeurs d’IA, le monde des processeurs s’interroge…

Sa fiche Wikipédia : Jim Keller

Plus d’information sur Jim keller becomes cto at-tenstorrent

Joan Clarke fut une figure majeure de la Seconde Guerre mondiale. Aux côtés d’Alan Turing, elle permit aux forces alliées de la Seconde Guerre mondiale de déchiffrer les messages de la fameuse machine à chiffrer Enigma. Son travail de cryptoanalyste lui valut d’être décorée de l’Ordre de l’empire britannique. Ses premiers pas dans le renseignement s’effectuèrent au sein d’un groupe de travail exclusivement féminin astucieusement surnommé “Les filles”.

Une revanche pour Clarke qui n’avait pas pu obtenir son diplôme de mathématicienne à Cambridge malgré d’excellents résultats, l’université n’en proposant pas aux femmes avant 1948. Le poste qu’elle occupa au sein des services de renseignement était officiellement celui de linguiste, car l’administration d’outre-Manche n’avait pas de protocoles en place pour recruter des femmes cryptoanalystes. Elle mourut le 4 septembre 1996 après une carrière complète au sein de l’administration britannique.

Membre de la Congrégation des sœurs de la charité de la bienheureuse Vierge Marie, Mary Kenneth Keller fut la première femme à passer un doctorat en informatique aux États-Unis. Elle obtint ce (durement gagné) titre universitaire le 7 juin 1965, quelques heures à peine après que le premier diplôme de la discipline eut été décerné à son confrère Irving C. Tang. Non contente de bousculer les normes des religieuses catholiques, elle entra aussi au prestigieux Dartmouth College des États-Unis où elle participa à l’élaboration de BASIC, un des langages de programmation de haut niveau les plus connus.

Elle créa également le département des sciences informatiques du Clarke College d’Iowa et le présida pendant deux décennies. D’après ses propres dires, “nous vivons une ère d’explosion de l’information […] et il est évident que l’information n’a aucun intérêt si elle n’est pas largement diffusée”. Le temps lui a clairement donné raison.

Naquit en 1922 dans la région de Worcestershire en Angleterre, son travail sur le langage assembleur et les ordinateurs ARC lui valent d’être reconnue aujourd’hui comme une pionnière de l’informatique.

Accompagnée d’une équipe de l’université de Birkbeck (Londres), elle prit en charge la programmation trois machines qui préparèrent le terrain pour l’ordinateur d’aujourd’hui. Elle travailla également sur l’aspect matériel des machines avec son époux. Elle est considérée comme l’autrice du premier langage assembleur.

Elle publia en 1958 un livre sur la programmation, chose extrêmement rare pour une femme à cette époque. En 1993, âgée de 71 ans, elle publiait encore un article scientifique qui se proposait “d’utiliser des réseaux neuronaux pour identifier les mammifères marins”. Femme de science, donc de progrès, elle ne cessa jamais d’imaginer, d’accompagner et de commenter les évolutions clés du monde des technologies.

Katherine Johnson fut l’une des “figures de l’ombre” de la Nasa, dont le destin est raconté dans le film de 2016. Décédée l’année dernière à l’âge de 101 ans, Johnson était physicienne, mathématicienne et ingénieure spatiale. Elle fut embauchée par la Nasa en tant que “calculatrice de couleur” (colored computer en anglais !!!), terme raciste employé à l’époque pour qualifier les Afro-Américaines qui effectuaient les calculs nécessaires aux engins spatiaux. Inconcevable de nos jours, mais cela donne un indice quant aux montagnes que dut soulever Katherine Johnson (parmi d’autres) pour voir ses compétences reconnues et utilisées à leur juste valeur.

Son expertise permit d’ailleurs de poser le premier humain sur la lune. En 1939, elle avait été la seule femme à intégrer le cursus de mathématiques à l’université de Virginie-Occidentale, après une décision de la Cour suprême des États-Unis. “Elle fut une héroïne américaine et son héritage de pionnière ne sera jamais oublié”, dira d’elle Jim Bridenstine, administrateur de la Nasa, au moment de sa mort.

Actrice et productrice de cinéma, Hedwig Kiesler (plus connue sous son nom de scène Hedy Lamarr) fut non seulement une actrice vedette des années 1930-40, mais aussi une inventrice longtemps oubliée. Entre deux tournages, elle imagina une nouvelle technologie, l’étalement de spectre par saut de fréquence. Cette technique de transmission est encore utilisée aujourd’hui dans le positionnement satellitaire, la technologie Wi-Fi et la téléphonie mobile.

Aidée par George Antheil (qui attribuera tout le crédit à Lamarr, expliquant que sa participation ne fut que d’ordre technique), elle déposa un brevet en 1941 qui fut jugé alors impraticable par l’armée des États-Unis. Ce n’est qu’en 1959, quand le brevet tomba dans le domaine public, qu’un grand nombre d’entreprises se mirent à exploiter la découverte de cette pionnière de l’informatique.

À 82 ans, l’Electronic Frontier Foundation lui décerna un prix et son anniversaire (9 novembre) marque désormais la journée de l’inventeur dans certains pays germanophones.

A la pointe du «machine learning», chercheur de l’Idiap et professeur à l’EPFL cherche à améliorer le coût computationnel de ses algorithmes.

Citation :

«Le secteur est phagocyté par les grosses entreprises, il y a toujours cette «tentation Google». Les meilleurs doctorants se voient proposer des salaires entre 200 000 et 500 000 francs suisses, c’est fou. Tous les ordres de grandeur sont différents: puissance des serveurs, quantité de ressources… Des infrastructures avec lesquelles le milieu académique peut difficilement se comparer.»

Sa page personnelle : François Fleuret

Claude Elwood Shannon (30 avril 1916 à – 24 février 2001) est un ingénieur en génie électrique et mathématicien américain.

Il est l’un des pères, si ce n’est le père fondateur, de la théorie de l’information.Pendant la Seconde Guerre mondiale, Shannon travaille pour les services secrets de l’armée américaine, en cryptographie, chargé de localiser de manière automatique dans le code ennemi les parties signifiantes cachées au milieu du brouillage. Son travail est exposé dans un rapport secret (déclassifié dans les années 1980 seulement), qui donne naissance après-guerre à un article, A Mathematical Theory of Communication (1948), qui fut repris en 1949 sous forme de livre publié par l’université de l’Illinois avec les commentaires de Warren Weaver, coordonnateur dans les services secrets. Cet ouvrage est centré autour de la problématique de la transmission du signal.

Ses travaux et découvertes mathématiques furent très utilisées au début des recherches en intelligence artificielle.

Geoffrey Hinton est un chercheur canadien spécialiste de l’intelligence artificielle et plus particulièrement des réseaux de neurones artificiels. Il fait partie de l’équipe Google Brain et est professeur au département d’informatique de l’Université de Toronto. Il a été l’un des premiers à mettre en application l’algorithme de rétropropagation du gradient pour l’entraînement d’un réseau de neurones multi-couches. Il fait partie des figures de proue de la communauté de l’apprentissage profond.

Les travaux de recherche de Hinton concernent principalement les réseaux de neurones artificiels en lien avec l’apprentissage automatique et l’étude de la mémoire ou de la perception. Il a été l’un des premiers chercheurs à avoir fait la preuve de l’utilisation de l’algorithme de rétropropagation pour l’entraînement de réseaux de neurones multi-couches. Il a co-inventé les machines de Boltzmann avec David Ackley et Terry Sejnowski. Ses autres contributions portent sur les représentations distribuées, les time delay neural network (en), le produit et mélanges d’experts, les machines de Helmholtz (en), la visualisation de données – il est co-inventeur de l’algorithme t-SNE.

Est reconnu comme l’un des plus grands experts mondiaux en matière d’intelligence artificielle et comme un pionnier de l’apprentissage profond. En 2018, Yoshua Bengio est l’informaticien qui recueille le plus grand nombre de nouvelles citations au monde, grâce à ses nombreuses publications. En 2019, il reçoit le Prix ACM A.M. Turing « le Nobel de l’informatique » conjointement avec Geoffrey Hinton et Yann LeCun pour leurs avancées en fondements conceptuels et en ingénierie qui ont fait des réseaux neuronaux profonds une composante essentielle de l’informatique.

Warren Weaver un scientifique américain, mathématicien et administrateur de la recherche.

Il est principalement connu comme un des pionniers de la traduction automatique et comme une importante figure de la promotion des sciences aux USA à travers la Fondation Rockefeller. Il a développé en 1944 la théorie de l’information en collaboration avec Claude Shannon. Il est aussi l’inventeur en 1938 du terme de biologie moléculaire.

Laurence Devillers, est professeure en informatique appliquée aux sciences sociales, en poste à l’Université Paris-Sorbonne 4 depuis 2011.

Elle a contribué à plusieurs projets nationaux (ANR Tecsan Armen, FUI Romeo, BPI Romeo25) et européens (Rex Humaine, Chist-era Joker6) dédiés aux « interactions affectives et sociales humain-robot ». Elle est membre de la CERNA (Commission de réflexion sur l’éthique de la recherche en sciences et technologies du numérique) de l’alliance Allistene. Elle a participé à la rédaction du rapport sur l’éthique du chercheur en robotique et a dirigé celui sur l’éthique en apprentissage machine9. Elle a participé au bureau de l’IDEX Paris-Saclay LIDEX ISN, Institut de la Société Numérique (Université Paris-Saclay) où elle a animé le pôle sur la co-évolution humain-machine dans le cadre de l’Institut de la société numérique. Elle est maintenant chargée de mission à l’institut de convergence pluridisciplinaire DATAIA de Paris-Saclay11 (intelligence artificielle et sciences des données) depuis 2017. Elle dirige un projet de l’institut DATAIA sur l’éthique de la robotique sociale : Bad nudge Bad robot avec des chercheurs en économie comportementale et des juristes, elle préside également la Fondation Blaise Pascal de médiation en mathématiques et informatique.

David Boggs, ingénieur électricien et informaticien, est décédé ce 19 février à Palo Alto (USA Californie), à l’âge de 71 ans. Au printemps 1973, tout juste diplômé de l’Université de Stanford, il avait commencé un stage au Xerox PARC, qui développait un nouveau type d’ordinateur personnel. Il travaillait à l’époque avec Bob Metcalfe, dont il était l’assistant. L’histoire veut que les deux hommes aient commencé à mettre au point le protocole de réseau, Ethernet, la même année. Mais ce n’est qu’en 1975 qu’ils ont publié un document intitulé Ethernet: Distributed Packet Switching For Local Computer Networks.

Sans ses travaux, pas de réseaux, pas de révolution de la communication informatique.

Ses travaux on préparé et fortement influencé ce que l’on utilise quotidiennement et naturellement de nos jour ; je ne pense pas qu’à Arpanet devenu Internet.

Elle est principalement connue pour avoir réalisé le premier véritable programme informatique, lors de son travail sur un ancêtre de l’ordinateur : la machine analytique de Charles Babbage. Dans ses notes, on trouve en effet le premier programme publié, destiné à être exécuté par une machine, ce qui fait considérer Ada Lovelace comme « le premier programmeur du monde ». Elle a également entrevu et décrit certaines possibilités offertes par les calculateurs universels, allant bien au-delà du calcul numérique et de ce qu’imaginaient Babbage et ses contemporains.

Également :

Timnit Gebru est née en Éthiopie ; Elle émigre aux États-Unis à 16 ans et est admise à l’université Stanford, où elle poursuit des études en génie électrique. Elle obtient son doctorat en informatique dans le laboratoire d’intelligence artificielle de Stanford en 2017. Elle effectue ensuite un post-doctorat à Microsoft, dans le laboratoire FATE (Fairness, Accountability, Transparency and Ethics in AI), dédié à l’égalité, la transparence et l’éthique en intelligence artificielle.

Elle est notamment l’auteure avec Joy Buolamwini de l’étude Gender Shades qui montre les biais des algorithmes de reconnaissance faciale qui reconnaissent moins facilement les personnes de couleur. En particulier, les femmes noires ont 35% moins de chances d’être reconnues que des hommes blancs. L’étude a des conséquences pratiques importantes sur les recommandations et interdictions des systèmes de reconnaissance faciale aux états-unis.

Dans un article de 2018 étudie les conditions de création et de maintenance des ensemble de données utilisés en apprentissage artificiel, et notent le manque de standardisation de la documentation de ces données. Plus généralement, elle s’interroge sur le fait que des questions comme: « Cette tâche a-t-elle un sens ? », « À qui appartiennent les données ? », « Comment sont-elles utilisées ? » ne sont que rarement posées, et que ce sont des questions sociales et non technologiques.

Lire aussi : Timnit Gebru, une chercheuse qui se bat pour donner des couleurs à l’intelligence artificielle

Publié sur Courrier International le 20 août 2022 (Réservé aux abonnés)

Considéré comme l’un des maîtres de la science-fiction, Isaac Asimov (1920-1992) a exploré des thématiques futuristes qui font écho aux grands défis actuels. Quel message d’espoir a-t-il à nous livrer ?

En 1923, Isaac Asimov a 3 ans quand ses parents émigrent de Russie aux États-Unis. Lecteur compulsif et passionné d’histoire, le gamin dévore les illustrés que vend son père dans une échoppe à New York. Devenu docteur en biochimie, après s’être consacré à l’enseignement universitaire, il se replie dans son bureau-bibliothèque pour tenter de répondre à cette question qui le taraude : « Où allons-nous ? » Pour y parvenir, il publiera plus de cinq cents livres : des romans et des nouvelles de science-fiction, ainsi que des ouvrages de vulgarisation scientifique. Auteur de trois cycles romanesques majeurs – Fondation, Robots et Empire –, Isaac Asimov a imaginé à quoi pourrait ressembler notre futur, proche et plus souvent lointain. Trois décennies après sa mort, son œuvre visionnaire fait encore écho aux grands défis d’aujourd’hui.

D’une cassette vidéo, avalée par un antique magnétoscope, émerge le visage d’Isaac Asimov. Pendant près d’une heure, recréé par une intelligence artificielle, son avatar nous livre un passionnant message testamentaire, construit à partir d’extraits des conférences, livres, préfaces, articles, entretiens et lettres personnelles qu’il a produits entre 1950 et 1989. Illustré par de nombreuses archives, le portrait que consacre à Asimov Mathias Théry ne donne qu’une envie : se (re)plonger dans son œuvre pour méditer ce que ce génial écrivain espérait pour nous, lui qui avait compris que « l’humanité n’a pas les moyens de gaspiller ses ressources financières et affectives dans d’interminables conflits dépourvus de sens ».

Blogueur, programmeur, entrepreneur, et investisseur, Sam Altman est l’un de ces talents protéiformes qui aiment à développer leurs aptitudes et leurs facultés sous le soleil de Californie. Né à Chicago le 22 avril 1985, le jeune Altman a cependant grandi dans la ville de Saint-Louis, Missouri, loin des plages qui bordent l’océan Pacifique. C’est son inscription à l’université de Stanford qui lui donnera l’occasion de venir au cœur de la Silicone Valley, au sud de la baie de San Francisco. Il n’ira cependant pas au bout de son cursus universitaire en abandonnant ses études lors de l’année 2005.

Après plusieurs créations d’entreprises, Il entre chez Open AI et développe des applications à base d’Intelligence Artificielles comme le processus associés. Ses grandes participations (réussite’s ?) sont le générateur d’images Dall-E et ChatGPT, son chatbot qui a réponse à tout ou presque.

Le meilleur moyen de se tenir au courant des activités du trépidant entrepreneur californien, c’est tout simplement de suivre son blog https://blog.samaltman.com/ où ce jeune homme vous dit tout sur sa vision des nouvelles technologies et de l’univers des start-up.

Mustafa Suleyman, né en août 1984, est un chercheur et entrepreneur britannique en intelligence artificielle. Il est le cofondateur et ancien responsable de l’intelligence artificielle appliquée chez DeepMind et désormais détenue par Alphabet. Sa nouvelle entreprise actuelle est Inflection AI cofondée avec Reid Hoffman.

C’est un chercheur et entrepreneur britannique en intelligence artificielle (IA). Il a cofondé DeepMind (une entreprise d’IA depuis rachetée par Google), et y a travaillé en tant que responsable de l’IA appliquée. Il est actuellement le dirigeant de Inflection AI, qu’il a cofondé en 2022.

Sa fiche Wikipédia : Mustafa Suleyman

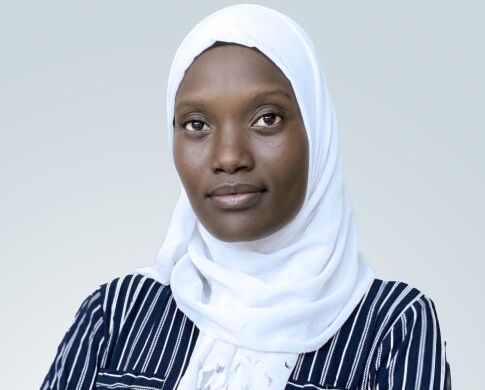

Cette pionnière en intelligence artificielle au Sénégal veut développer une application permettant aux cardiologues de prédire les risques de maladies cardio-vasculaires.

C’est un peu par hasard que Fatou Lo Niang, doctorante en intelligence artificielle appliquée à la médecine, s’est mise à étudier l’informatique. Son baccalauréat en poche, en 2014, elle est orientée par le ministère de l’enseignement supérieur vers l’université de Bambey, à environ 130 kilomètres à l’est de Dakar, pour suivre une licence en réseaux téléinformatiques et maintenance, puis un master en système informatique. Bien loin de ses premiers choix, qui étaient la médecine et la biologie. « J’étais passionnée par les sciences naturelles depuis toute petite. J’ai eu du mal à accepter ce choix qui m’était imposé et j’ai eu des difficultés à m’adapter », se rappelle la scientifique âgée de 30 ans, originaire de Thiaroye Gare, dans la banlieue de Dakar.

La pionnière oubliée de l’intelligence artificielle ?

Née le à Cherchell (Algérie) et morte le à Ballainvilliers est une informaticienne française un peu trop oubliée aujourd’hui.

Elle s’est notamment illustrée dans le domaine de l’architecture des ordinateurs. En 1959, elle participe au développement du mini-ordinateur CAB500, puis devient cheffe de projet sur le mini-ordinateur Mitra 15, avant de passer à des recherches sur les architectures parallèles et l’intelligence artificielle. Plus tard, en 1978, elle participe à la création de la CNIL.

Sa fiche Wikipédia : Alice Recoque

Autre article : Qui est Alice Recoque, la pionnière oubliée de l’intelligence artificielle ?