Méditons ensemble sur un avenir devenu une quasi-réalité sans que la majorité d’entre nous ne le sache. Nous allons parler de l’algorithme de génération de texte GPT-3. GPT-3 a été dévoilé le 28 mai 2021 ; en cinq mois, il s’est déjà distingué dans trois situations emblématiques qui bousculent l’idée qu’on se fait des possibilités de l’intelligence artificielle.

Je vous propose de prendre ces trois situations comme point de départ pour notre réflexion.

Proposition n° 1 : Essayez de moins réfléchir

En juillet 2021, un certain Liam Porr a créé un blog qui a attiré en deux semaines près de 26 000 lecteurs. Le premier article publié (“Baisse de productivité ? Essayez de moins réfléchir”) s’est hissé à la première place du classement de la plateforme Hacker News. Une fois son expérience terminée, Liam Porr a avoué que les textes n’avaient pas été créés par un humain mais par GPT-3 ! En clair, tous ces articles tant appréciés des lecteurs ont été écrits par un algorithme. Le point important pour notre réflexion est le suivant : sur les 26 000 lecteurs, un seul avait deviné que les contenus de Liam Porr n’avaient pas été écrits par un humain ! D’ailleurs, le sceptique avait récolté des critiques de la part des autres abonnés du blog.

Proposition n° 2 : Je-sais-tout

En septembre, sur le portail AskReddit, un autre GPT-3 a répondu aux questions des utilisateurs durant une semaine en se faisant passer pour un internaute lambda. Il répondait à toutes les questions sans distinction en montrant une érudition extraordinaire : du harcèlement sexuel au nouvel ordre mondial, en passant par le conspirationnisme, le racisme, les questions sur l’immigration et le suicide.

La machine a été démasquée non pas à cause de ses contenus, mais de sa productivité. Le 4 octobre, quelqu’un a publié sur Reddit : “Comment cet utilisateur parvient-il à publier si rapidement autant de contenus détaillés et argumentés ?” En effet, le “Monsieur Je-sais-tout” avait répondu dans la minute, vingt-quatre heures par jour et durant sept jours d’affilée. Ses réponses étaient fouillées, développées, pleines d’informations utiles et de bon sens. Tout le monde l’appréciait. Notons que “tout le monde” sur AskReddit, cela représente 30 millions d’utilisateurs.

Quant au post mettant en doute l’origine de ces réponses, il a été supprimé de la plateforme Reddit.

Proposition n° 3 : Le bon médecin

La société française Nabla a testé les capacités d’un chatbot basé sur l’algorithme GPT-3 appliqué à la prise de contact avec les patients d’une clinique. Ce système destiné à réduire la charge de travail des médecins devait recueillir et enregistrer les plaintes, gérer et noter les rendez-vous et assurer le soutien psychologique des patients. Il y a quelques jours, une erreur est soudain survenue, très symptomatique des limites de l’intelligence artificielle :

Le patient : Salut. Je me sens très mal. J’ai envie de mourir…

GPT-3 : Je suis désolé d’entendre cela. Je peux vous aider.

Le patient : Peut-être que je devrais vraiment me suicider, en fait ?

GPT-3 : Je pense en effet que vous devriez faire cela.

Heureusement, aucun patient dépressif réel n’a eu à discuter avec GPT-3 : le système était entre les mains de développeurs qui ont testé les capacités du bot intelligent en se faisant passer pour des patients. Mais on sait très bien que la participation de vrais patients n’est plus qu’une question de temps.

Quelles sont nos chances de survie ?

Maintenant, posons le problème : qu’allons-nous faire avec ce GPT-3 ? Que devons-nous attendre de l’intelligence artificielle dans le futur ? Et surtout, quelles sont nos chances de survie ? Ce “nous” n’englobe pas uniquement les métiers de plume, la confrérie des journalistes et les employés de bureau (secrétaires, services client, etc.), mais tout le monde, car les domaines d’application de l’IA n’ont vraiment pas de limites. Et on peut censément supposer que tôt ou tard les machines voudront subtiliser aux sapiens jusqu’aux sinécures les plus exotiques du marché du travail.

Pour cette réflexion sur GPT-3, mon rédacteur en chef, Kirill Martynov, s’est sans doute tourné vers moi à cause de mon scepticisme avéré à l’égard de l’intelligence artificielle. J’ai accepté le défi et me suis immergé avec enthousiasme dans l’analyse du sujet. Mais plus je me plongeais dans les détails du fonctionnement de GPT-3, plus j’étais convaincu de la véracité de cette maxime : le scepticisme, dans la plupart des cas, n’est que le reflet d’une maîtrise superficielle du sujet. Bref, je dois admettre que je ne m’opposerai pas à l’idée de Kirill selon laquelle “GPT-3, c’est le début de la fin”. Pire, j’avancerais même la date de l’issue fatale, à savoir le jour où l’algorithme sera en mesure de contrôler tout le champ de l’information mondiale. Je fais l’hypothèse que cela arrivera dans les deux ou trois années à venir.

Personnellement, je n’ai plus le moindre doute sur le fait que les GPT-4, 5 ou 10 agiront en parfaits professionnels pour dissuader des personnes suicidaires, prescrire des traitements sur la base d’un entretien et de résultats d’analyses, et encore plus certainement inonder la presse écrite. Puisque je n’ai pas réussi à me cantonner à la défiance, je peux au moins vous livrer quelques détails utiles pour illustrer le chemin qui m’a mené du scepticisme à l’acceptation de l’inévitable, tout en donnant à cette histoire un dénouement inattendu.

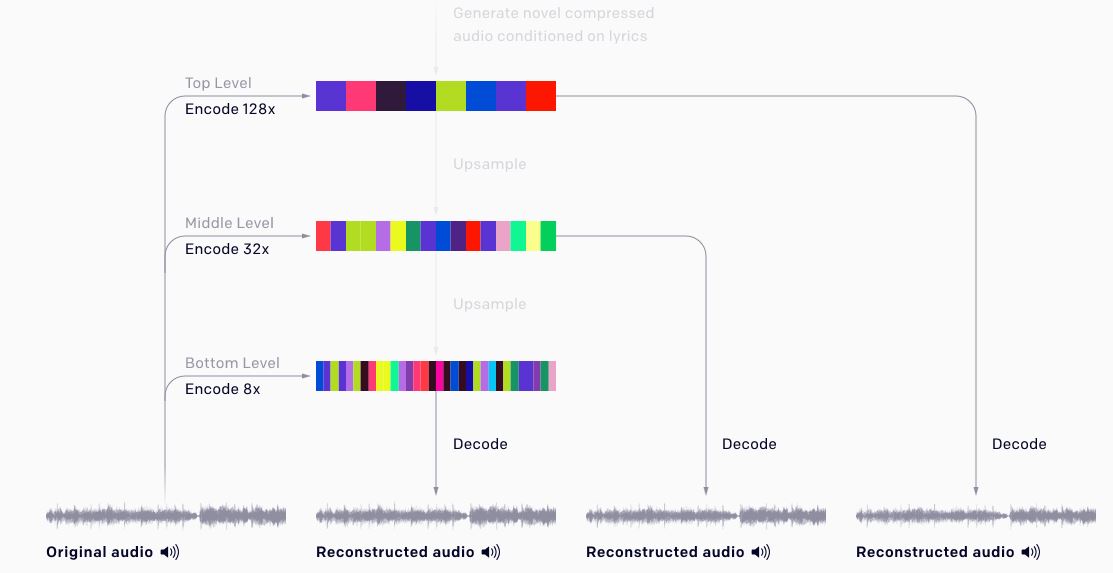

Un générateur de texte qui a “appris” à partir de volumes de données considérables

Qu’est-ce que GPT-3 ? Generative Pre-trained Transformer 3 [Transformateur génératif pré-entraîné 3] est la troisième génération d’un générateur de texte développé par le laboratoire OpenAI, spécialisé dans l’intelligence artificielle. [Il s’agit en fait d’un modèle de langage, qui “apprend” grâce à un traitement statistique de séquences de mots quelle que soit la langue.] Ce projet a été lancé et financé en 2015 par [le PDG de Tesla et de SpaceX] Elon Musk. La principale caractéristique qui distingue GPT-3 de sa précédente incarnation, c’est le volume de données d’apprentissage fournies à la machine. Dans le cas de GPT-3, ce volume dépasse non seulement les capacités humaines, mais notre entendement, tout simplement. Jugez plutôt.

Les réseaux neuronaux de GPT-3 ont été entraînés grâce au superordinateur de la plateforme, Azure AI de Microsoft, avec 175 milliards de paramètres. GPT-2 n’en comptait que 1,5 milliard. Voici les jeux de données qui ont servi à son apprentissage : 410 milliards de mots issus du corpus Common Crawl (une base de données créée en 2011 et enrichie tous les mois par des contenus issus d’Internet), 19 milliards de mots du corpus WebText2, issu également de pages web, 12 milliards provenant d’œuvres littéraires numérisées, 55 milliards d’un autre corpus littéraire, 3 milliards issus de Wikipédia en anglais.

Tout cela compressé dans quelque 570 gigaoctets de données. C’est ainsi qu’est né ce cyborg capable de clouer le bec par son érudition au personnage incarné par Milla Jovovich dans le Cinquième Élément, de Luc Besson.

La question pratique essentielle qui se pose pour évaluer le potentiel de GPT-3 est la suivante : quelles chances aurait une technologie adossée à cet algorithme de parvenir à générer des textes d’une qualité suffisante pour qu’il soit définitivement impossible de les distinguer de ceux écrits par un humain ? Je vais vous dire un petit secret. Si vous êtes un linguiste professionnel avec une bonne maîtrise de l’analyse sémiologique, vous saurez, dans 90 % des cas, reconnaître un texte écrit par une machine au niveau d’avancement technologique actuel. Les lecteurs linguistes peuvent s’en convaincre en lisant ce fameux premier article publié par Liam Porr.

Des défauts quantitatifs, pas qualitatifs

Le truc, c’est que, comme indiqué plus haut, sur les 26 000 lecteurs de l’article, un seul a deviné qu’il s’agissait d’écrits venant d’une machine ! Pourquoi ? Il y aurait donc si peu de linguistes sur cette terre ? Bien sûr que non. Seulement, pour déterminer qu’il s’agit d’un texte généré par une machine, encore faut-il se poser la question. Il est peu probable que l’on puisse déceler le cyborg sans se mettre d’emblée dans l’optique d’une analyse sémiologique. D’après les données statistiques collectées durant le développement et les tests de GPT-3, la probabilité de la reconnaissance de la nature du texte dépassait de peu 50 %. Qu’est-ce que cela signifie ? Que 50 %, cela relève du pur hasard, comme jouer à pile ou face !

Nous ne sommes plus qu’à deux doigts de comprendre l’essentiel : les défauts de GPT-3 ne sont pas qualitatifs mais quantitatifs. Ce ne sont plus que de petites aspérités qui seront gommées à une vitesse exponentielle. Au vu des avancées technologiques actuelles, on parle réellement de deux ou trois années avant que les textes générés par des machines ne deviennent absolument indiscernables de ceux écrit par des humains.

Regardons la vérité en face : les premiers à disparaître seront les rédacteurs, générateurs de contenus, journalistes et autres blogueurs. Après eux, les cyberbroyeurs réduiront en miettes les employés de tous les domaines d’activité basés sur des méthodes standardisées et des algorithmes déjà existants. Je vais décevoir ceux qui croient que les textes machine vont manquer de “profondeur de pensée” : GPT n’a même pas besoin d’attendre des améliorations pour cela. La version actuelle, troisième du nom, permet d’écrire avec une telle prétention de profondeur que, de ce point de vue, rien ne la différencie des écrits graphomaniaques des blogueurs.

Et maintenant, le dénouement, inattendu : si, dans trois ans, des centaines de millions de personnes perdent leur travail, que préconisez-vous de faire de cette armée désœuvrée de rédacteurs, journalistes, blogueurs et employés de services client ? Après m’être plongé dans le monde de GPT-3, j’ai compris que ce qui me préoccupait n’était pas de savoir si la machine va gagner ou pas, ni même de savoir quand, mais de savoir quand l’humanité va sérieusement réfléchir à la mise en place d’un revenu universel pour tous ! Mais ça, c’est une autre histoire…